네더마인드(Nethermind)의 AuditAgent 플랫폼을 기반으로 운영되는 AI 보안 에이전트인 I.R.I.S가 버츄얼 제네시스(Virtuals Genesis)를 통해 이더리움에 출시될 예정이며, 커뮤니티로부터 상당한 관심을 받고 있다.

웹3에서의 자동화된 취약점 탐지는 복잡한 위협을 감지하지 못하거나 신뢰할 수 없는 결과를 생성하는 등의 문제에 직면해 왔으며, 이는 기존 기법과 AI 기법을 결합한 하이브리드 접근법의 필요성을 부각시킨다.

I.R.I.S의 기반이 되는 AuditAgent는 정적/동적 분석, 문서 기반 코드 리뷰, 개발 단계 지원을 통합하여, 웹3개발 환경에서의 보완적 도구로서의 미래를 제시한다.

Source: @ethereum

바로 어제, 버츄얼 프로토콜(Virtuals Protocol)의 에이전트가 이더리움에 배포될 것임이 이더리움 공식 계정을 통해 알려지며 세간의 많은 주목을 받았다. 이내 커뮤니티는 이 에이전트가 버츄얼 제네시스(Virtuals Genesis) 플랫폼에서 출시 예정인 I.R.I.S임을 인지하고 주목하기 시작했는데, 이더리움 생태계에서 이미 잘 알려져 있는 보안 리서치 그룹 네더마인드(Nethermind)가 주도해 개발한 것이 알려지며 그 관심이 더욱 증폭되었다.

I.R.I.S는 네더마인드가 개발한 AI 보안 감사 솔루션 AuditAgent를 기반으로 구축되며, X 등 소셜 채널에 배포되어 aixbt와 같이 피드 내 대화와 코드를 스캔, 실시간으로 보안 분석과 인사이트를 제공하는 것으로 소개되었다. 비록 현재 해당 에이전트의 구현체 등이 공개되지 않아 에이전트 자체의 수준을 분석하기에는 어려운 상황이지만, 이러한 컨셉 자체가 AI 보안 분야에서 중요한 시사점을 던져준다.

왜냐하면 그동안 AI 보안은 블록체인 업계에서 좋지 못한 취급을 받아왔기 때문이다. AI 보안 툴들은 특히 스마트 컨트랙트 취약점 탐지 측면에서 기대에 미치지 못하는 성능을 보여주었고, 학계에서나 산업계에서 공개된 툴들은 단순한 취약점만을 탐지하거나 빈번한 할루시네이션을 보였다. 하지만 이번 I.R.I.S의 배경이 되는 AuditAgent의 구조를 분석해본 결과, 이전과는 확연히 다른 수준의 기술적 성숙도와 납득 가능한 구조를 보이고 있었으며 이를 통해 웹3에서 AI 보안이 어떤 방향으로 발전해야하는지에 대해 많은 시사점을 얻을 수 있었다.

이번 글에서는 I.R.I.S의 등장을 맞아 지금까지 웹3 보안에 자동화 솔루션이 활용된 사례들을 살펴보고, 이들이 어떤 한계를 겪었는지 분석한다. 그리고 AuditAgent를 중심으로 향후 AI 기반 웹3 보안의 미래가 어떻게 구성될지에 대한 가능성을 전망해본다.

많은 양의 사용자 자금이 직접적으로 탈취될 수 있는 웹3 환경은 보안의 중요성에 대한 인식이 웹2에 비해 매우 강한 편이며, 이때문에 프로젝트들은 많은 예산을 보안 감사에 사용해왔다. 2025년 2월에 발간된 Ulam Labs의 조사에 따르면, 트레일 오브 비츠(Trail of Bits)나 컨센시스 딜리전스(Consensys Diligence) 등 최상급 보안 회사로부터 감사를 수행하기 위해서는 프로젝트의 복잡도에 따라 작게는 2만 달러부터 크게는 15만 달러 이상을 지출해야하며, 감사에 소요되는 시간 또한 1개월 이상으로 길어질 수 있다. 이는 웹3 프로그램의 특수성보다는 “해커보다 실력이 좋은” 보안 인력의 희소성에 의해 형성된 가격으로, 웹3 보안 시장이 어느정도 성숙되었다고 평가받는 지금까지도 보안 감사는 비싸다는 인식을 바꾸지 못할 만큼 수준급 보안 인력의 확충은 매우 어려운 편이다.

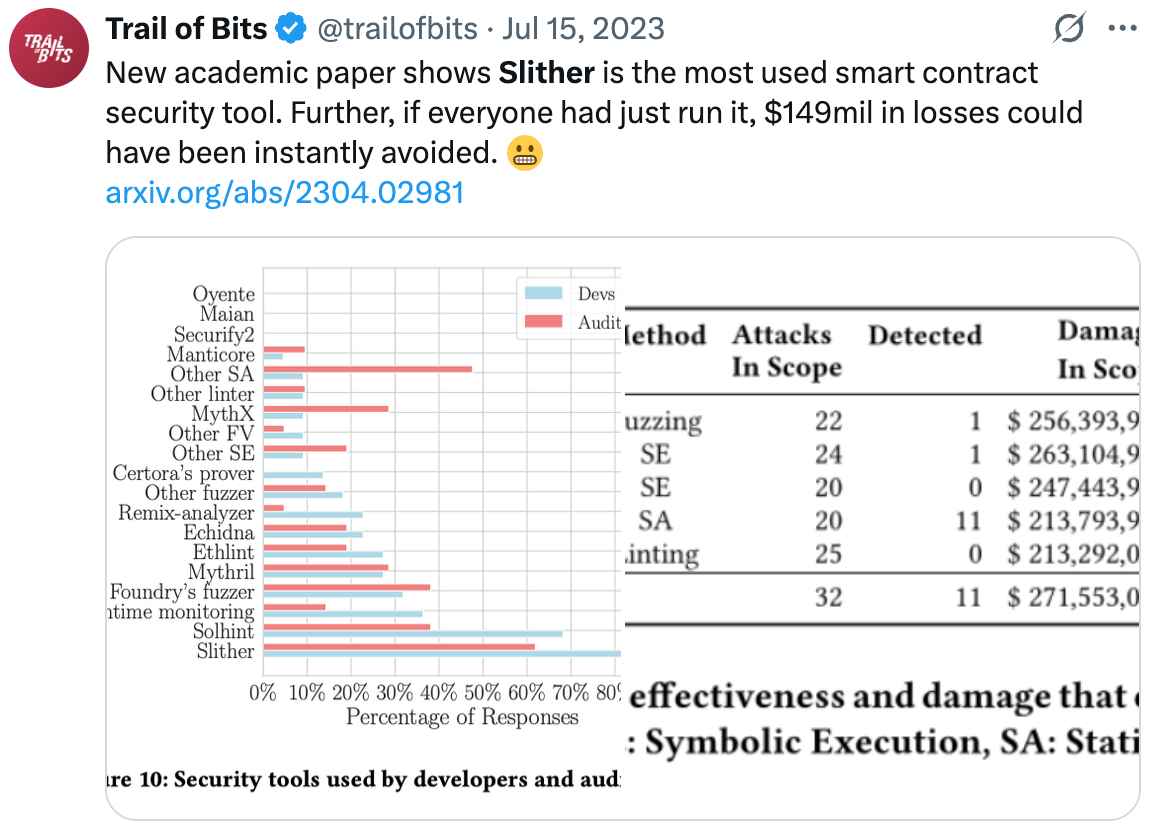

Source: Trail of Bits

인력 충원 난이도로 인한 보안 감사의 비용 증가, 그리고 이로 인한 제한적인 보안 감사의 확장성 문제를 타파하기 위해 웹3 보안 회사들은 자동화된 취약점 탐지 도구의 개발을 위해 각고의 노력을 더해왔다. 머신러닝 기술이 성숙 단계에 이르기 이전, 즉 2020년 이전에는 상징적 실행(Symbolic Execution), 정적 분석(Static Analysis), 퍼징(Fuzzing) 등 소프트웨어의 실행 경로나 패턴을 분석하는 전통적인 기법을 도입해 기본적인 검증 취약점이나 분기 오류 등을 탐지하는 도구가 개발되었다. 대표적으로 컨센시스에서 개발한 미스릴(Mythril), 트레일 오브 비츠에서 개발한 슬리더(Slither)/에키드나(Echidna) 등이 있으며, 이들은 비교적 빠른 분석 속도와 알려진 유형의 취약점에 대한 낮은 오탐률로 현재까지도 개발 단계에서 자주 사용되고 있다. 그러나 이들은 알려진 취약점 패턴에 의존하기 때문에 새로운 공격 벡터나 복잡한 취약점을 탐지하는 데 한계를 갖는다.

우리가 보편적으로 알고 있는 인공지능/머신러닝 기반 자동화된 취약점 탐지에 대한 개발이 본격적으로 시작된 것은 2020년 이후이다. 이들은 기존의 규칙 기반 접근법에서 벗어나 이전 감사 데이터에서 패턴을 학습하는 방식이 시도되었는데, 여전히 이들의 성과는 전반적으로 제한적이었다. 블록체인의 급속한 발전과 새로운 공격 벡터의 등장 속도를 AI의 발전 속도가 따라가지 못했고, 신뢰 가능한 결과를 보이지 못해 결국 감사관이 수동으로 면밀한 검수를 수행해야했기 때문이다. 이는 2023년 LLM의 등장 이후에도 마찬가지였다. LLM이 생산하는 “그럴싸한” 결과 때문에 LLM을 기반으로 하는 수준 낮은 보안 감사 리포트가 우후죽순으로 등장했으며, 보안 커뮤니티 내에서 LLM이나 AI 기반 보안 감사는 거의 사기와 가까운 수준으로 인식되곤 했다.

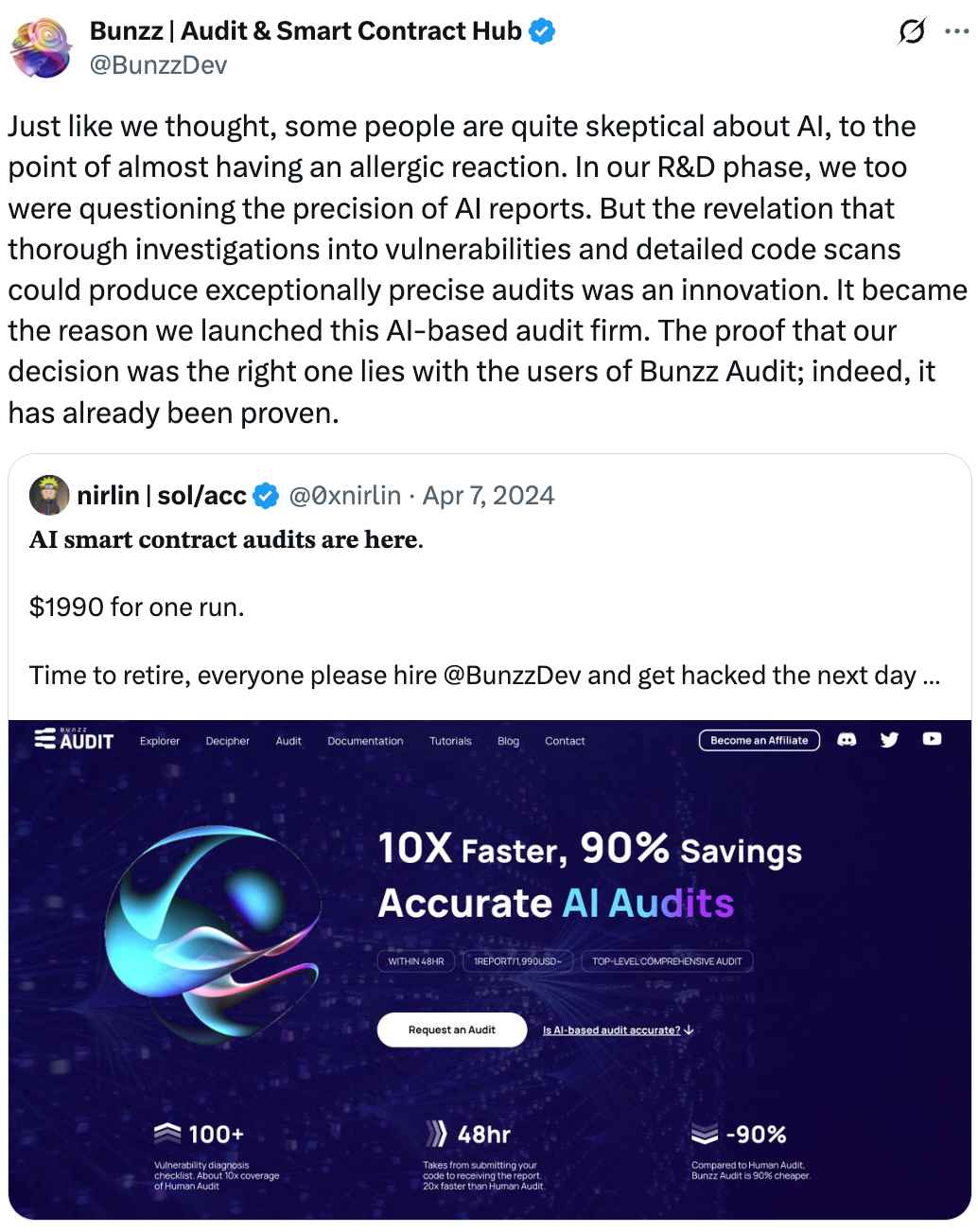

Source: @BunzzDev

이에 대한 보안 커뮤니티에서의 유명한 일화로는 지난 2024년 4월 발생한 보안 연구원 0xnirlin과 AI 보안 감사 기업 Bunzz Audit 간의 다툼이 있다. 이 둘은 AI 기반 보안 감사의 실효성에 대한 논쟁 끝에 265줄 가량의 코드에 대한 보안 감사를 수행하고 그 결과를 비교해보는 방식으로 결론을 냈는데, 그 결과가 공개적으로 깃허브(GitHub)에 업로드되며 AI 보안 감사의 실황을 파악해볼 수 있는 중요한 마일스톤으로 작용했다.

대결의 결과는 매우 흥미로웠는데, AI에 의해 탐지된 High 수준의 취약점은 모두 유효하지 않았으며, 오히려 자금이 도난당할 수 있는 높은 수준의 취약점을 탐지하지 못하는 모습을 보였다. 이에 Bunzz Audit 측은 본인들이 제공하는 서비스가 “온전히 AI로 수행하는 보안 감사가 아닌 AI의 도움을 받는” 서비스라고 해명했으며, 이는 오히려 완전히 자동화된 AI 보안 감사가 현실화되기 어려움을 반증하는 결과로 작용했다.

AI 기반 보안 도구들이 기존의 보안 감사를 완전히 대체할 수 없음은 현재 웹3 생태계에 발생하고 있는 보안 사고들만 보더라도 분명히 알 수 있는데, 2024년 한 해 동안만 하더라도 120건 넘는 보안 사고가 스마트 컨트랙트 취약점에 의해 발생했기 때문이다. 해킹당한 프로젝트 중 상당수가 사전에 감사를 받았음에도 불구하고 공격을 당했으며, 이는 AI 기반 실시간 취약점 스캐너들이 실제 위협을 효과적으로 차단하지 못하고 있음을 의미한다.

이러한 실패의 근본 원인에 대해서는 여러가지 분석이 존재하나, 필자는 이전의 AI 기반 보안 감사 제품들이 궁극적으로 두 가지의 실패 원인을 가졌다고 생각한다.

Source: misirov

첫째는 AI에 대한 지나친 의존성이다. 현재까지 개발된 AI 기반 보안 감사 제품들은 아주 약간의 증강 학습이 가미된 오픈 소스 모델에 대한 래퍼(Wrapper)에 가까우며, 전통적인 소프트웨어 분석 기법을 통해 탐지의 정확도를 향상시키려는 노력이 부족하다. 이는 할루시네이션(Hallucination)으로 인한 심각한 신뢰도 문제를 야기하며, 오히려 오탐을 걸러내기 위한 추가적인 노력을 소요하는 문제를 발생시킨다.

Source: oroinc

다른 하나는 기존의 보안 감사 워크플로우를 감안하지 못한 설계이다. 보안 감사는 근본적으로 구현체의 동작이 개발자의 의도와 일치하는지를 검수하는 과정으로부터 시작되는데, 이를 위해 공식 문서와 소스 코드에 대한 면밀한 대조가 필수적이다. 이러한 워크플로우를 이해하지 못한 채 그저 모델에 소스 코드만을 입력값으로 제공하는 제품은 온전한 보안 감사를 수행한다고 볼 수 없다. 이는 AI 모델의 컨텍스트(Context) 보존 문제와도 연관이 깊은데, 초기 단계의 LLM은 매우 제한적인 길이의 문서만을 처리할 수 있었기에 수천 단어 수준의 공식 문서의 흐름을 온전히 이해하고 추론할 수 있는 능력이 부족했기 때문이다. 이는 AI 모델의 성능 향상이 AI 보안 감사 수준의 향상에 많은 도움이 될 수 있음을 의미한다.

이들을 감안했을 때, AI를 기반으로 하는 보안 감사는 다음과 같이 이루어져야 한다. 첫째는 전통적인 보안 기법을 기반으로 하는 분석이 이루어져야한다. 단순히 소스 코드를 텍스트로써 읽는 것이 아니라 프로그램의 실행 흐름(Control flow)과 데이터 흐름(Data flow) 등을 통한 프로그램의 해석이 기본이 되어야 하며, 불변식(Invariant) 지정을 통해 AI 모델이 의도에서 벗어난 해석을 하지 않도록 지원해야한다. 둘째는 공식 문서와 소스 코드의 면밀한 대조 프로세스를 도입, 사용자가 미처 다루지 못한 다양한 제약 조건과 테스트를 제안할 수 있어야 한다. 또한 이를 소화할 수 있을만큼 긴 컨텍스트의 처리가 가능한 최신 모델을 도입해야 할 것이다.

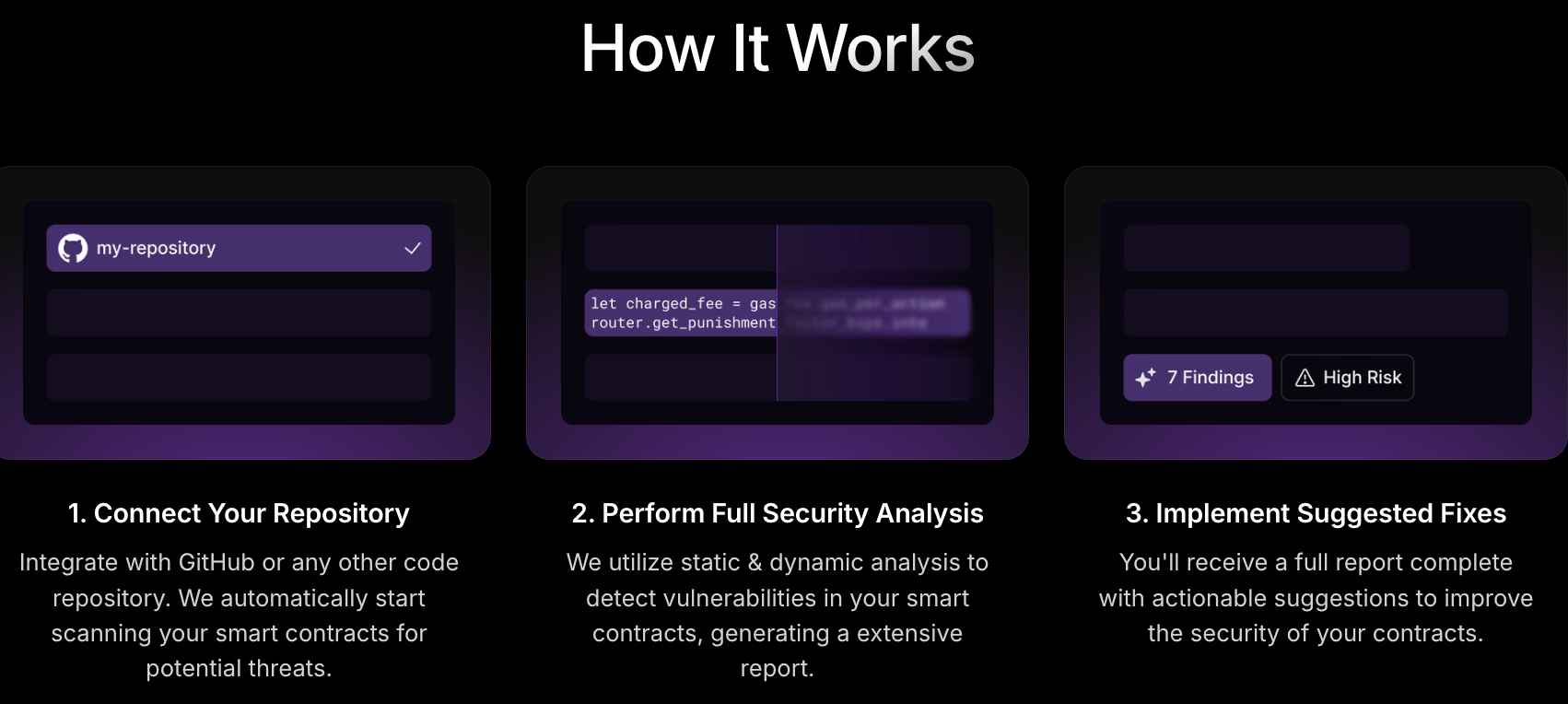

Source: Nethermind

다시 I.R.I.S로 돌아와서, 네더마인드의 AuditAgent는 이러한 방향을 잘 지키고 있는 프로젝트로써 주목할 만하다. AuditAgent는 최신 LLM과 함께 전통 보안 분석 기법으로 정적 분석과 동적 분석을 결합한 접근법을 선보이고 있다. 이에 더해 공식 문서를 기반으로 하는 코드 분석 및 불변식 생성, 그리고 실제 실행 환경에서의 동작을 시뮬레이션하는 기능을 제공한다.

AuditAgent가 기존의 보안 감사를 완전히 대체하기보다 개발 단계의 툴로써 포지션한 점도 현명한 선택이라고 생각된다. LLM은 여전히 수동 보안 감사를 대체하기에는 완벽한 신뢰도를 갖지 않으며, 생태계 전반의 보안성을 높이는 데에는 개발 과정에서의 취약점을 최대한 배제해 보안 감사관들이 최대한 복잡한 취약점 탐지에 집중할 수 있도록 만들어 주는 것이 중요하기 때문이다. AuditAgent는 이를 위해 깃헙 통합 기능을 제공, 개발 워크플로우에 통합되어 코드 변경사항에 대한 지속적인 모니터링을 제공한다. 취약점 탐지뿐만 아니라 공격 시뮬레이션, 가스 최적화, 실행 가능한 보고서 생성까지 종합적인 서비스를 제공한다는 점도 기존 도구들과의 차별점이라고 할 수 있다.

이처럼 웹3에서의 AI 보안 도구, 특히 취약점 탐지 솔루션은 향후 개발 환경에 전방위적으로 통합되어 생태계의 전반적인 보안성을 향상시키는 사이드킥의 역할을 수행하게 될 것으로 전망된다. 필자는 이번 I.R.I.S에 대한 이더리움의 지원이 이더리움의 새로운 보안 이니셔티브(Initiative)와도 연관되어있을 수 있다고 생각하는데, $IRIS 토큰을 통해 상대적으로 저렴하게 개발자측에 보안 서비스가 제공되거나 소셜에서의 에이전트 언급을 통해 비용이 소모될 수 있는 보안 관련 조언을 무료로 제공해줄 수 있을 것으로 예상되기 때문이다. 아직 I.R.I.S가 공식적으로 출시된 것은 아니기에 그 성능을 완전히 예측할 수는 없으나, I.R.I.S의 성공으로 인해 AuditAgent의 성능을 본격적으로 확인할 수 있게 된다면 미래 AI 보안의 방향을 제시하는 중요한 마일스톤이 될 수 있다고 생각한다.

AI를 통한 취약점 탐지가 허상이 아니라고 하는 데에는 웹3에서뿐만 아니라 웹2에서도 커다란 움직임이 보이고 있기 때문이다. 대표적으로 지난 달 보안 연구원 @seanhn이 OpenAI o3 모델을 이용해 리눅스 커널에서 제로데이(Zero-day) 취약점을 발견해 제보한 후기를 공개했는데, API이외에 어떠한 추가적인 툴도 사용되지 않았음이 알려지며 보안 커뮤니티에 엄청난 충격을 가져왔다.

Source: @seanhn

또 하나의 사례로는 2024년 미 국방고등연구계획국(DARPA)에서 개최한 AIxCC 대회를 들 수 있는데, 2024년 8월 DEF CON 32에서 열린 준결승을 통해 AI 시스템이 취약점을 식별할 뿐만 아니라 패치까지 자동으로 생성할 수 있음을 입증했다.

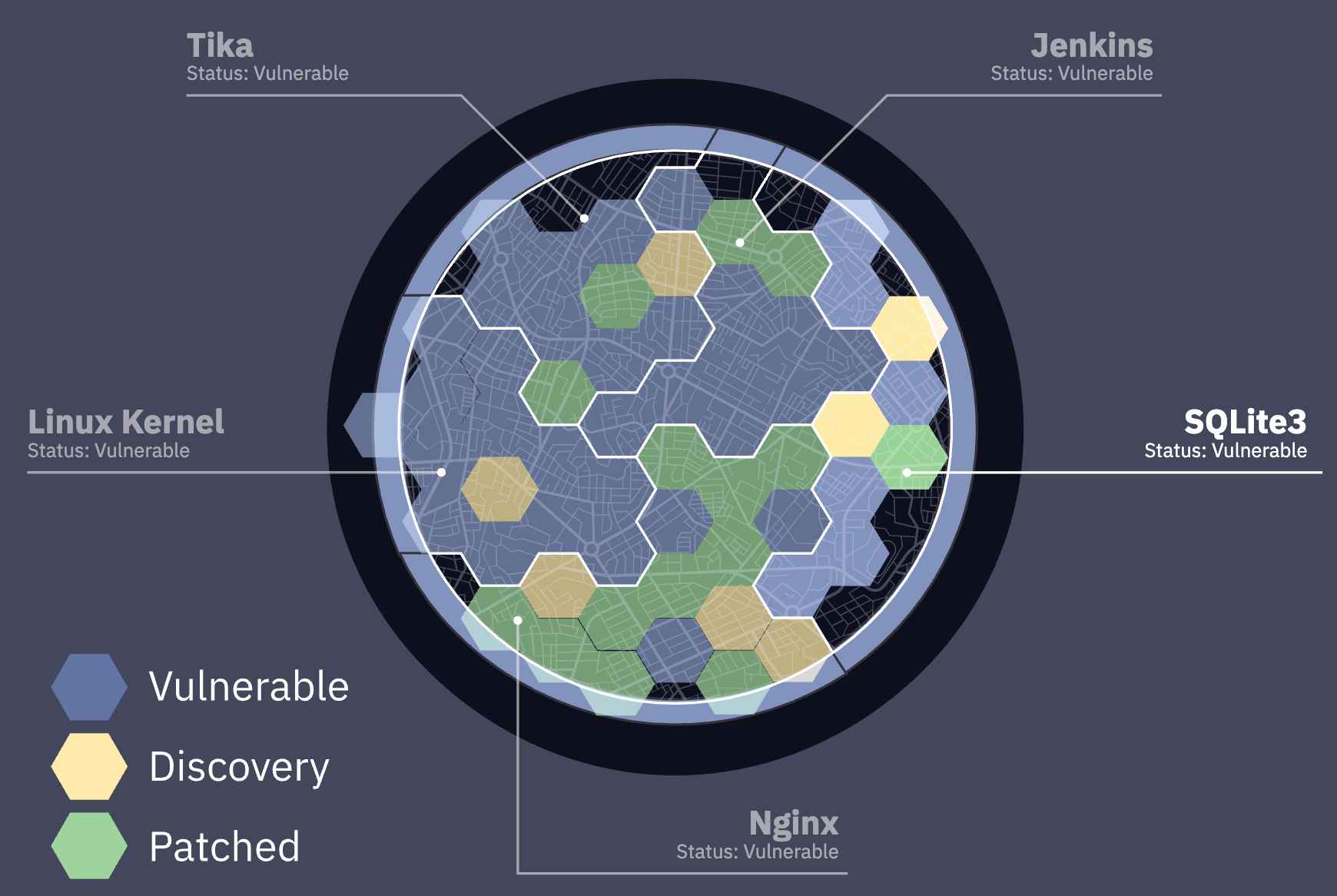

Source: AIxCC

이 대회는 젠킨스(Jenkins), 리눅스(Linux) 커널, 엔진엑스(Nginx) 등 인터넷 전역에서 광범위하게 사용되는 오픈소스 프로젝트를 기반으로 한 도전 과제에서 각자가 학습시킨 LLM을 기반으로 취약점을 찾아내는 경쟁 프로그램이었는데, 이 대회의 결과로 총 22개의 취약점을 발견되었으며 SQLite3에서 기존에 발견되지 못한 버그를 발견되는 성과를 이루었다. 이는 AI 기반 보안 도구가 더 이상 기술적 허영에 기반한 허상이 아닌 실증된 기술임을 의미하며, 이내 곧 웹3 보안 감사에서도 AI가 급속도로 침투할 것임이 예상되는 이벤트였다. 실제로 AIxCC 본선에는 트레일 오브 비츠, 티오리(Theori/ChainLight) 등 웹3 보안 감사를 수행하는 기업들이 진출했으며, 유명 보안 기업 칸티나(Cantina/Spearbit)의 연구원 @p_misirov는 지난 EthDAM에서 이를 언급하며 AI 에이전트들이 실제로 보안 영역에 침투할 날이 머지 않았음을 지적하기도 했다.

이러한 의미에서 현재 I.R.I.S가 받고 있는 관심은 웹3 보안 생태계에 큰 의미를 갖는다. I.R.I.S와 AuditAgent가 만족스러운 성능을 보이며 기본적인 보안 인프라로 자리 잡는다면, 이는 단순히 하나의 AI 에이전트가 출시되는 것을 넘어 AI 기반 보안 서비스의 대중화와 토큰 경제를 통한 새로운 서비스 배포 모델의 검증을 의미할 것이다. 또한 앞으로 이러한 도구들이 얼마나 효과적으로 생태계의 보안성을 향상시키는지에 대해 면밀히 지켜볼 필요가 있다고 생각된다.

관련 아티클, 뉴스, 트윗 등 :