현재 AI가 완전한 개인화와 확장가능한 방식의 발전을 달성하지 못하는 이유는 기술·데이터·윤리·비용 등 여러 구조적 한계 때문이며, 이를 해소하기 위해서는 기존의 중앙화된 방식과는 다른 새로운 접근이 필요하다.

그라디언트는 데이터·연산·통신 등 AI 추론 및 학습 전 과정에 필요한 각각의 기능들을 분산화된 레이어로 재설계하고 이를 유기적으로 통합해, 누구나 참여·검증·협업할 수 있는 확장 가능한 오픈 AI 인텔리전스 풀스택을 구축하고 있다.

그라디언트는 다원화된 사회의 다양한 컨텍스트에 최적화된 확장형 오픈 인텔리전스 인프라로 자리매김할 잠재력이 뚜렷하지만, 실질적으로 시장 우위를 확보하기 위해서는 다양한 레이어의 참여자들의 인센티브를 정렬하고, 치열한 경쟁 환경 속에서 모듈 간 상호운용성과 시장 효율을 결합한 뚜렷한 네트워크 효과를 창출해야 하는 과제를 안고 있다.

“어떻게 하면 나의 제품 혹은 서비스가 지닌 가치를 더 많은 고객들에게 일관되게 전달해, 그들에게 최대의 효용을 제공할 수 있을까?”

이는 산업의 종류를 망라하고, 사업을 운영하는 모든 기업이라면 공통적으로 마주하는 근본적인 질문이다. 하지만 가치란 언제나 상대적이며, 사람마다, 문화마다, 또 시대마다 다르게 해석되는 법이다. 새로운 제품이나 서비스는 분명한 의도 속에서 만들어지지만, 그 의도가 모든 고객에게 일관되게 전달되기는 어렵다. 때로는 본래의 의도나 철학이 왜곡되는 경우도 적지 않다.

이 때문에 글로벌 서비스들은 ‘현지화(Localization)’에 막대한 노력을 기울이곤 한다. 다수의 고객을 대상으로 브랜드가 지닌 일관된 품질과 경험을 유지하기위해, 각 시장의 문화적·경제적 특성에 맞게 서비스를 최적화함으로써 전달하려는 가치와 각 지역의 소비자가 받아들이는 가치 사이의 간극을 최소화하는 것이다.

하지만 오늘날의 추세는 이제 이러한 지역 단위의 현지화를 넘어, 개인 수준의 맞춤화, 즉 ‘초개인화(Hyper-personalization)’의 단계로 나아가고 있다. 사회가 복잡해지고 상호작용이 다변화되면서, 개인은 자신만의 취향과 개성을 드러내길 원하고, 자신이 이용하는 서비스 역시 그에 걸맞은 독특하고 편리한, 최고의 경험이길 기대한다. 결국 서비스는 이제 지역에 기반한 고객 서비스 제공이 아니라, 각 개인마다 상황·감정·행동 패턴까지 이해하고 반응해야 하는 시대에 들어선 것이다.

이러한 변화는 AI와 데이터 및 통신 기술의 눈부신 발전 덕분에 가속화되어올 수 있었다. 기업들은 단순히 거시적인 환경 분석과 산업 분석, 그리고 소비자 분석을 넘어 첨단 기술들을 통해 실시간으로 개인의 민감 데이터부터 행동 데이터까지 더욱 더 방대한 범위의 데이터를 수집하여 분석할 수 있게 되었기 때문이다.

하지만 우리는 이러한 트렌드가 나아가는 과정에 물음을 던질 필요가 있다 - 많은 AI 기반의 서비스들이 수억명 이상에 달하는 전 고객들에게 “정말로 완벽히 초개인화된 경험”을 제공할 수 있을까? 우리가 누리고 있는 이 서비스가, 오히려 나의 개성을 망치고 선택의 폭을 제한하는 것은 아닐까? - 기존의 중앙집중식 AI 학습 파이프라인은 요소마다 구조적인 한계를 지니고 있기에, 과연 우리가 꿈꾸는 초개인화시대가 지금 진행되고있는 AI 혁신으로부터 정말 실현이 될 수 있을지에 대한 의문을 낳는다.

이번 아티클은 그라디언트(Gradient) 사례를 통해, 기존 AI 기술들의 이러한 구조적인 한계를 극복하기 위해 등장한 개방형 인텔리전스 플랫폼의 구축 방식을 살펴본다. 그라디언트는 에이전트의 추론 과정에 필요한 백엔드 상호작용을 세분화하고, 이를 모듈형 아키텍처 기반의 탈중앙화 스택으로 재구성·통합함으로써, 다양한 산업 전반에서 확장 가능한 에이전트 생태계의 핵심 엔진을 구축하는 것을 목표로 한다.

사실 많은 측면에서 현재 AI 기술들이 완벽히 개인화된 서비스를 모두에게 제공하는 것은 구조적으로 매우 어렵다는 것을 알 수 있다. 가장 단편적으로는, 개개인마다 변화무쌍한 광범위한 컨텍스트를 완전히 실시간으로 반영하기는 현실적으로 매우 어렵다는 데에 있다. 인간의 감정과 취향, 행동 패턴은 매순간 끊임없이 변화하며, 이를 중앙화된 서버로 전송하고 결과를 다시 반영하기까지는 필연적인 시간 지연(time lag)과 정보 손실이 존재한다. 따라서 오늘날의 AI는 언제나 ‘지연된 개인화(delayed personalization)’, 즉 과거 데이터를 기반으로 한 예측적 근사치에 머무를 수밖에 없다.

이외에도, 데이터·윤리·경제·거버넌스 등 여러 측면에서의 구조적인 제약도 존재한다. 개인화가 정교해질수록 AI는 사용자의 행동, 위치, 감정, 건강 상태 등 민감한 정보를 요구하게 되고, 이는 필연적으로 개인정보 보호와 충돌할 수밖에 없다. 현재 GDPR이나 개인정보보호법 등 주요 규제들은 기술 기업들이 개인을 얼마나 깊이 이해할 수 있는지에 대해 명확한 경계를 설정하고 있지만, 결국 이처럼 기술이 요구하는 깊이보다 사회가 허용하는 깊이가 더 얕은 구조적 불일치가 존재하는 한, 우리는 완전한 형태의 개인화 서비스를 온전히 경험하기 어려울 것이다.

설령 규제적으로 데이터 주권이 보장되거나, 사용자들이 자발적으로 데이터를 제공할 의향이 있다 하더라도 AI의 작동 방식은 여전히 불투명하다. 대부분의 모델은 수백만 개의 매개변수가 상호작용하는 블랙박스 형태로 작동하며, 사용자는 자신이 어떤 데이터와 논리를 기반으로 특정 결과를 받았는지 알 수 없다. 이러한 불투명성은 서비스에 대한 신뢰를 근본적으로 약화시킨다. 더 나아가, 모델은 복잡하게 섥힌 학습 데이터에 내재된 편향을 그대로 반영할 뿐만 아니라, 이미 수집된 데이터 조차 이미 개인화된 컨텐츠의 행동 데이터인 경우도 비일비재한 경우가 있어 오히려 선택지를 좁히고 편향을 강화하는 ‘개인화의 역설’을 초래하기도 한다.

경제적 측면에서도 완전한 개인화 솔루션을 제공하는 것은 비효율적이다. 사용자를 세부적으로 분류하여 별도의 모델을 설계하고 운영할수록 막대한 연산 자원과 인프라 비용이 필요하기 때문이다. 이러한 구조적 부담 속에서 AI 산업은 점차 소수의 대형 플랫폼으로 집중되고 있으며, 동시에 새로운 모델을 탐색하거나 실험하려는 연구자와 기업들의 진입 가능성은 낮아지고 있다. 심지어 운영되고 있는 대부분의 기존 서비스들 역시 “충분히 개인화된 경험”과 “운영 효율성” 사이에서 절충점을 찾을 수밖에 없다.

물론, 이러한 과정 속에서 발전해 온 기존의 중앙집중식 AI 모델들이 지닌 효율성과 범용성의 장점은 여전히 분명하다. 방대한 데이터를 통합하고 일반화된 솔루션을 도출하는 능력은 편의성과 생산성 측면에서 여전히 높은 가치를 지니기 때문이다. 따라서 대형 AI 모델 제공자들이 앞으로도 다양한 분야에서 새로운 솔루션을 제시하며 성장을 이어갈 가능성은 충분하다.

하지만 AI 기술이 진정으로 개인화된 솔루션을 제공하여 품질을 높이고, 보다 창의적이며 다변화된 모델의 등장을 가능캐해 확장성을 확보하며 산업 전반의 새로운 혁신을 열어가기 위해서는 기존의 중앙화된 방식과는 또 다른, 새로운 접근 역시 필요하다. 즉, AI가 사회 전반으로 더욱 깊숙이 확산되어 시너지를 일으키기 위해서는, 보다 개별 맥락(Context)을 정교하게 반영할 수 있는 새로운 형태의 아키텍처와 거버넌스 패러다임이 등장해야 하는 것이다. 이는 단순한 기술적 고도화를 넘어, AI가 데이터를 수집하고 학습하며 추론하는 전 라이프사이클 전반이 더욱 투명하여 신뢰할 수 있고, 개방적으로 설계되는 과정을 포함한다.

그렇다면 이처럼 ‘확장 가능한 AI’ 세상을 만들기 위해서 기존 AI 아키텍처를 어떻게 재설계할 수 있을까?

확장 가능한 AI란 결국 세 가지 요소를 포함한다고 생각한다. 첫째, 사용자가 자신의 데이터를 검증가능한, 신뢰할 수 있는 네트워크 상에서 원하는 형태의 모델에 선별적으로 적용할 수 있을 것. 둘째, 이 모델이 학습 및 추론을 위해 원활히 작동할 수 있도록 충분한 연산 자원이 제공될 것. 셋째, 에이전트가 구동되는 일련의 통신 파이프라인이 단일 지점에 의존하지 않아 병목현상이나 끊김 없이 호스팅될 수 있을 것. 즉, 자본과 인프라에 종속된 기존의 중앙집중적 구조를 넘어, 유연하고 분산된 환경 속에서 누구나 자신만의 AI를 구축하고, 통제하고, 운영할 수 있는 조건을 마련하는 것이 핵심이다.

그라디언트 팀은 이 문제의 해답을, 각 기능을 분산 환경에 최적화된 프로토콜과 프레임워크 형태로 구축한 뒤 이를 하나의 유기적인 스택으로 통합하는 방식에서 찾았다. 이를 통해 데이터 소유권을 보장하는 한편 연산 자원, 통신 환경까지 모두 분산화하여, 누구나 참여·검증·협업할 수 있는 신뢰할 수 있는 개방형 AI 인텔리전스 엔진을 구축하는 것을 목표로 한다.

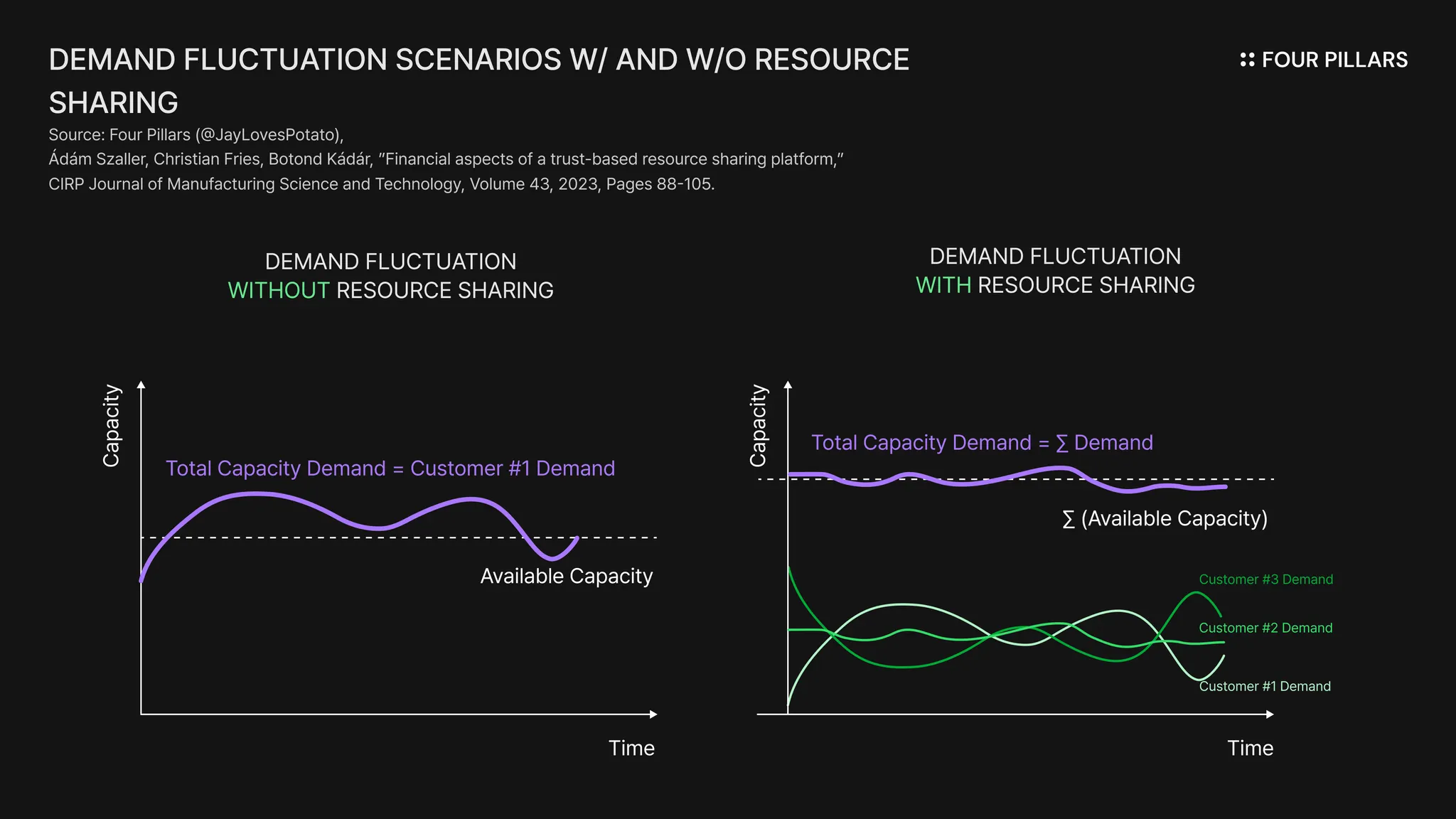

후에 살펴볼 것이지만, 모든 분산화된 스택을 재설계함에 있어 그라디언트 팀이 추구해왔던 설계 원칙의 핵심은 전 세계 곳곳에 흩어진 유휴 연산 자원 및 다양한 컴퓨팅 환경을 하나로 통합하고 조율하는 능력에 있다. 이러한 방식은 중앙 서버에 모든 작업을 집중시키는 기존 구조와 비교했을 때 다음과 같은 장점을 갖는다.

각 참여자가 자신의 환경에서 직접 모델 학습에 참여할 수 있어 진입 장벽이 크게 낮아진다.

데이터가 중앙 서버에 공유되는 대신 자신의 환경에서 데이터를 공유하고 상호작용하므로, 프라이버시 보호가 용이하고 온전히 본인이 소유하는 지역·도메인 특화 모델을 보다 정교하게 구성할 수 있다.

수많은 유휴 자원을 활용해 작업을 조율하기 때문에 중앙 서버의 부하를 줄일 수 있고, 결과적으로 더 안정적이고 끊김 없는 통신 컨텍스트를 통해 실시간 추론 성능을 강화할 수 있다.

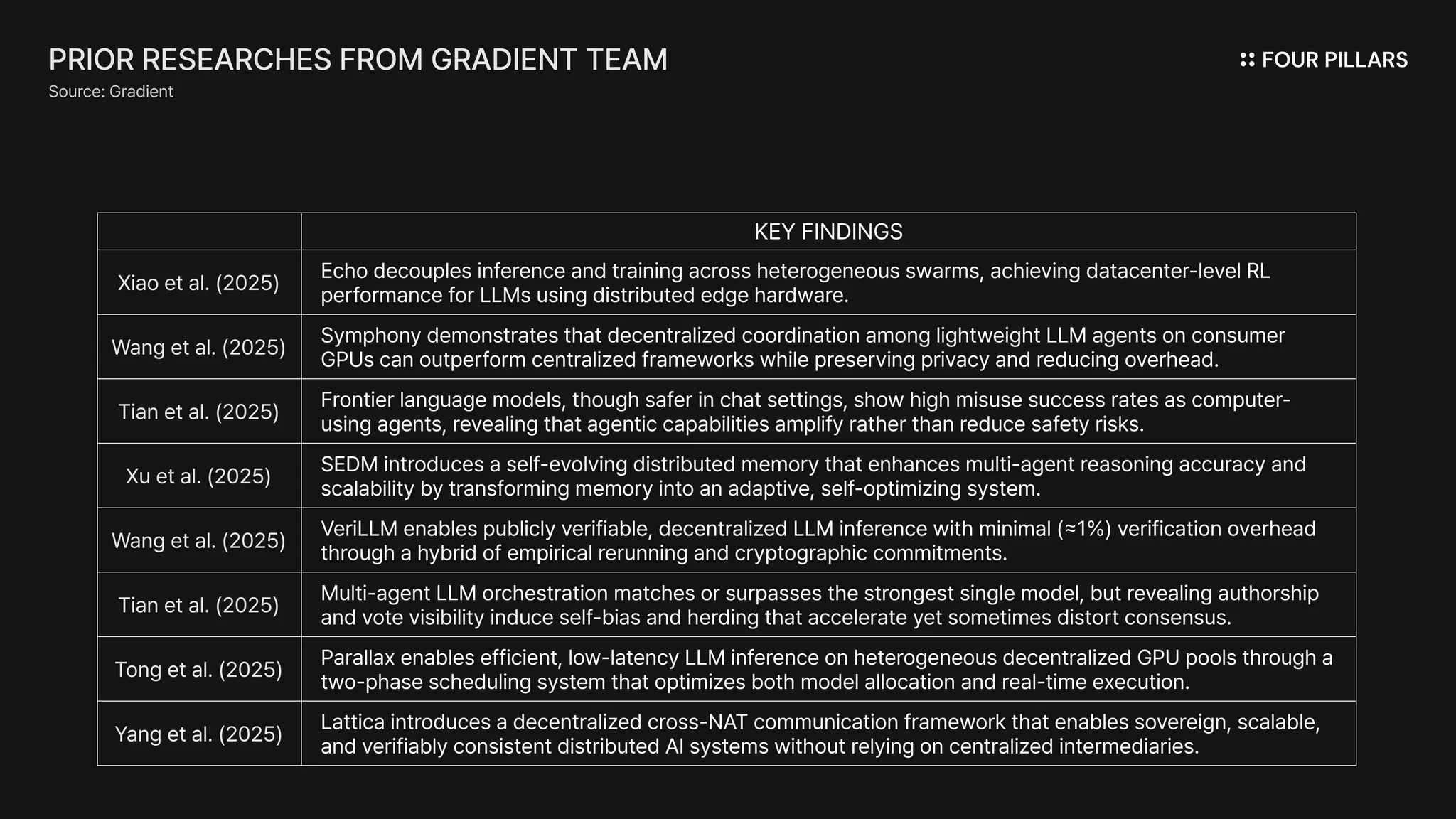

UC 버클리, 카네기 멜론, ETH 취리히 등 세계 유수의 대학과 Google, Apple, ByteDance 등 글로벌 테크 기업 출신 연구원들로 구성된 그라디언트 팀은, 8 여 편에 달하는 학술 저널 및 연구 결과물을 통해 그라디언트 팀이 만들고자 하는 분산화된 인프라 스택의 각 요소들과 각각이 전달할 수 있는 가치에 대해 꾸준히 연구해왔다. 풀스택 아키텍처를 모두 재구축하는 이러한 접근은 각 기능의 독립성과 확장성을 유지하면서도, 새로운 모델을 유연하게 도입·통합할 수 있게 하므로 전체 파이프라인의 운영 효율성과 신뢰성이 극대화되는 구조를 가능하게 만든다.

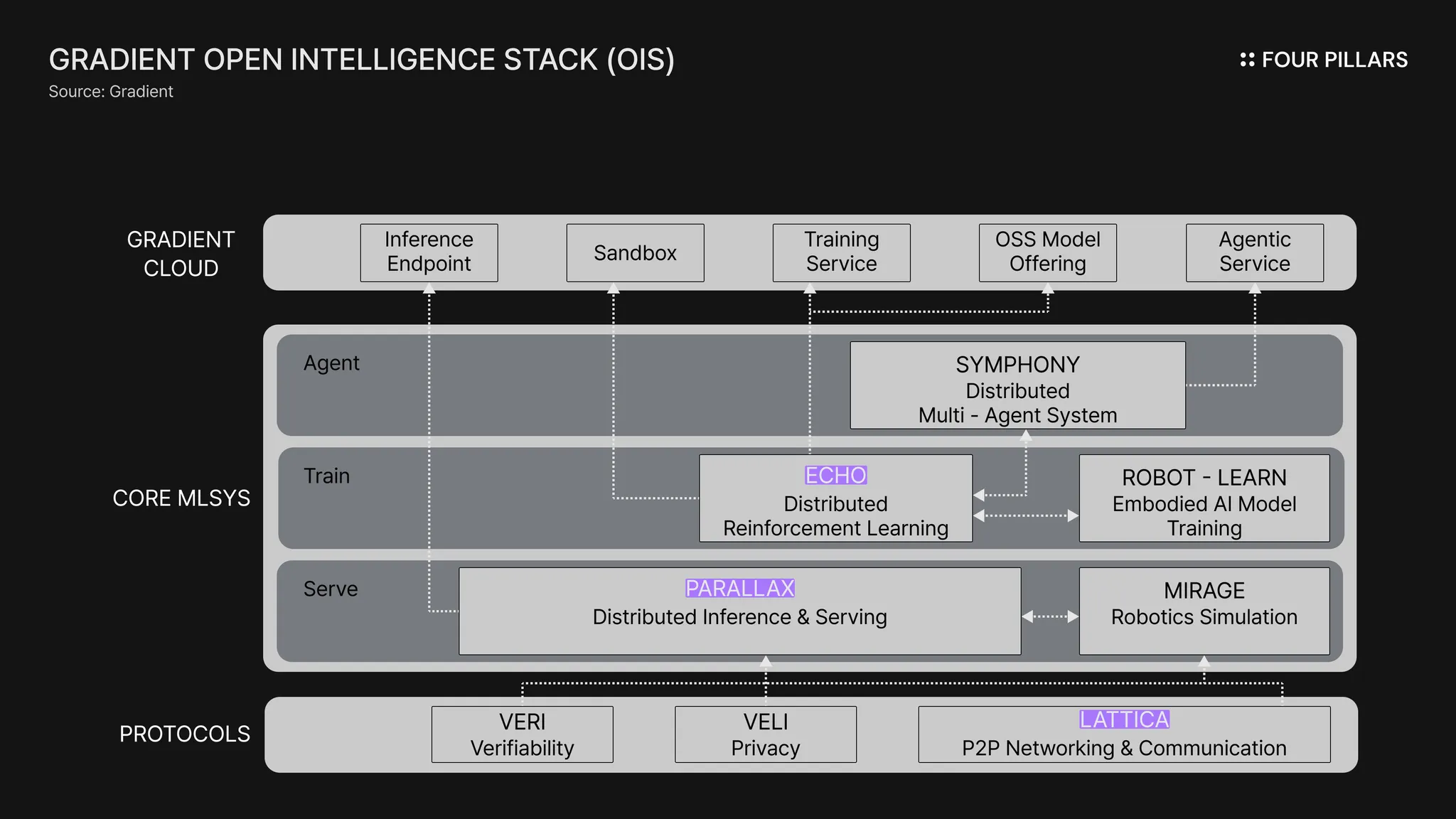

그라디언트 팀이 해당 연구 결과들을 바탕으로, 현재까지 공개한 인프라 레이어 및 서비스는 총 4가지 종류이다.

Lattica: 다양한 환경간의 매끄러운 연결을 제공하는 P2P 데이터 전송 프로토콜

Parallax: 이기종의 GPU‧CPU를 엮어 대형 LLM 추론을 병렬 처리하는 분산 AI 프레임워크

Echo: 사용자들의 각 디바이스 상에서 강화학습을 지원하는 훈련 엔진

Gradient Cloud: 위 3가지 레이어를 기반으로 여러 AI 학습 모델에 대한 추론 엔드포인트를 제공하는 플랫폼

3.3.1 Lattica — 오픈 인텔리전스를 위한 통신 & 조율 레이어

가장 먼저, Lattica는 쉽게 말해 - 점점 세분화되고 목적 중심적으로 발전하는 AI 활용 환경 속에서, 다양한 에이전트들이 각자의 맥락에서 추론하고, 협력하고 상호작용할 수 있도록 돕는 기저 통신(Communication) 및 조율(Coordination) 레이어라 할 수 있다.

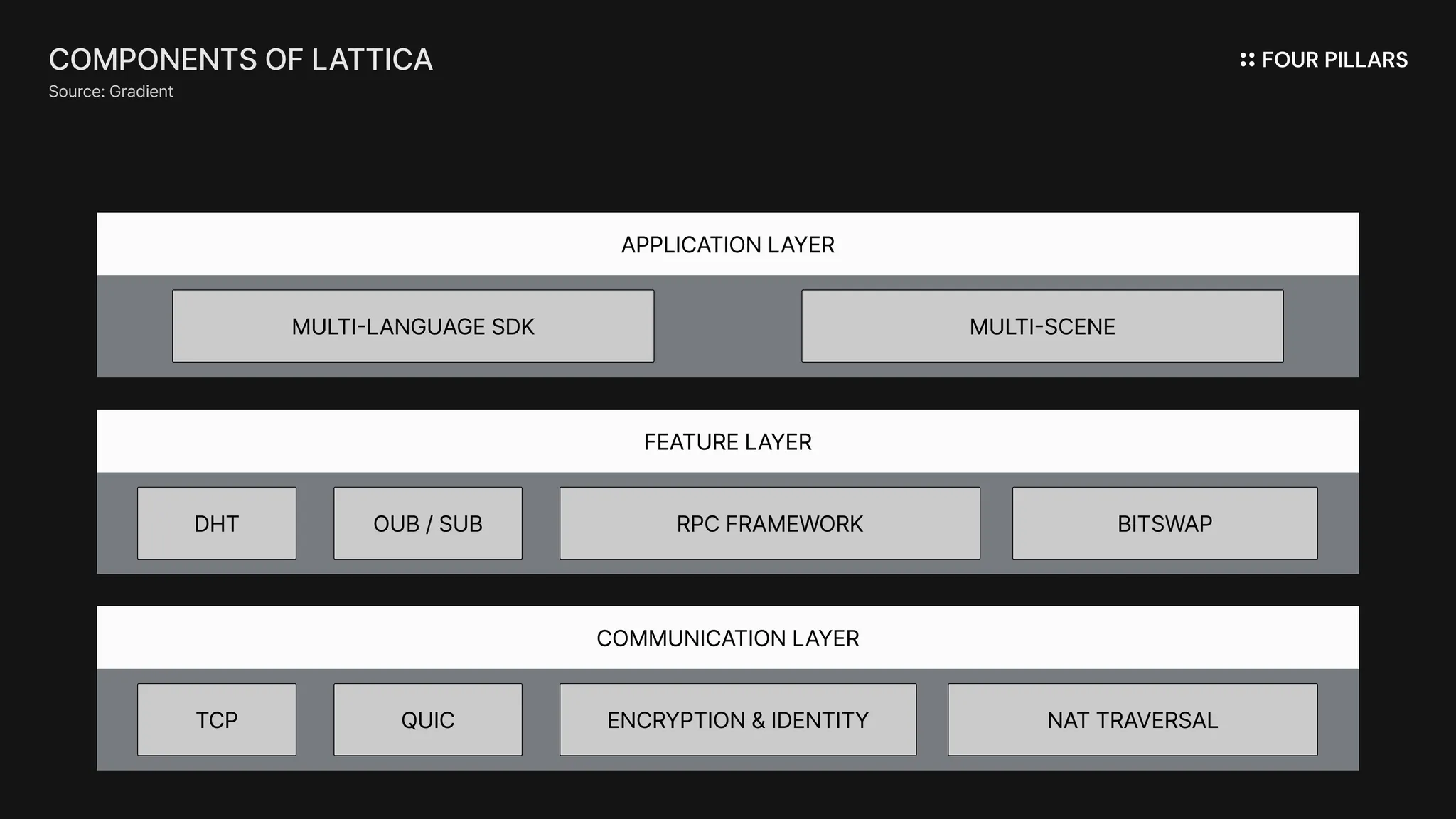

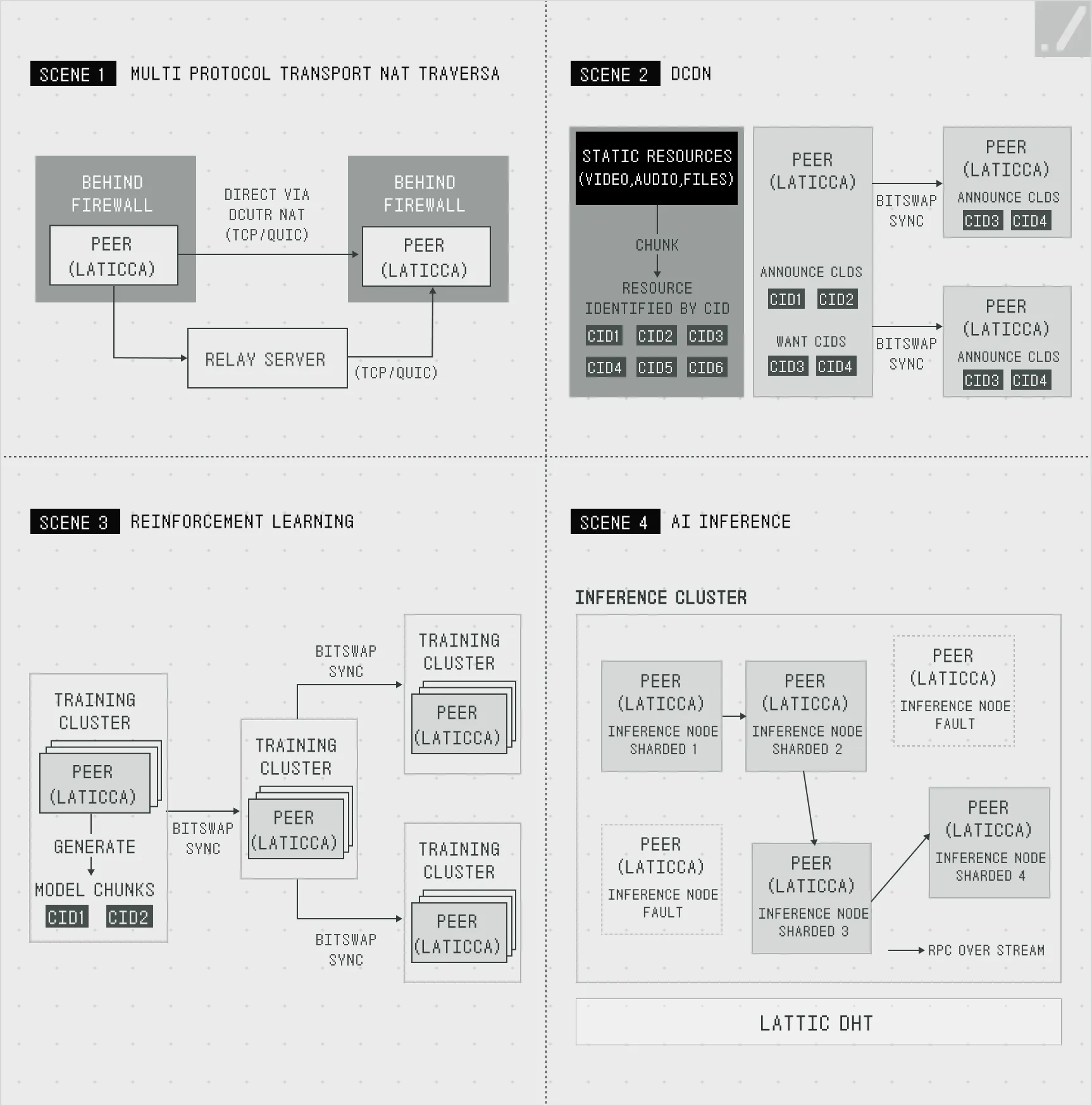

Lattica는 NAT 트래버설(NAT traversal)*, 분산 해시 테이블(Distributed Hash Table, DHT)**, 분산 콘텐츠 네트워크(DCDN), 그리고 libp2p 스트림 기반 RPC 프레임워크 등 통신 계층과 프로토콜 피처 계층, 그리고 애플리케이션 계층 등의 다양한 계층을 하나의 스택으로 통합하고 추상화하여, 데이터센터·GPU·브라우저 노드·엣지 디바이스 등 서로 다른 환경 간에도 유연하고 매끄러운 연결을 보장한다.

*NAT 트래버설(NAT traversal)은 내부 네트워크의 여러 기기가 하나의 공인 IP 주소를 공유해 외부와 통신하는 NAT(Network Address Translation) 환경에서, 보안상의 이유로 직접적인 P2P 통신이 어려운 두 기기 간 연결을 가능하게 하는 기술이다.

**DHT는 중앙 서버 없이 여러 컴퓨터 노드에 키-값 쌍을 분산하여 저장하고 검색하는 시스템이다.

Source: Gradient | 분산형 AI를 위한 4가지 시나리오

Lattica의 통신 오케스트레이션 과정을 요약하면 다음과 같다 - 모델 세그먼트나 데이터 청크는 개별 (엣지) 노드에 캐시되고, 해당 노드의 유효성은 실시간으로 감지되어 ‘가용성 맵(availability map)’에 전파된다. 이후 오케스트레이터는 맵을 탐색하여 데이터 공유를 위한 최적의 피어를 매칭하고, 그라디언트의 학습 엔진은 이 통신 결과를 피드백 받아 피어 선택, 부하 분산, 라우팅 전략을 실시간으로 개선함으로써 네트워크 전체의 효율성과 안정성을 지속적으로 향상시키는 구조이다.

결과적으로 개별 노드들은 중앙화된 서버의 개입 없이 어떤 환경에서도 로컬에서 AI 학습 및 추론을 수행하기 위해 P2P 방식으로 데이터를 교환할 수 있기 때문에 사용자들은 Lattica를 활용하여 협업형 강화학습이나 대규모 분산 머신러닝과 같은 복잡한 지능형 연산을 한층 원활하게 수행할 수 있다.

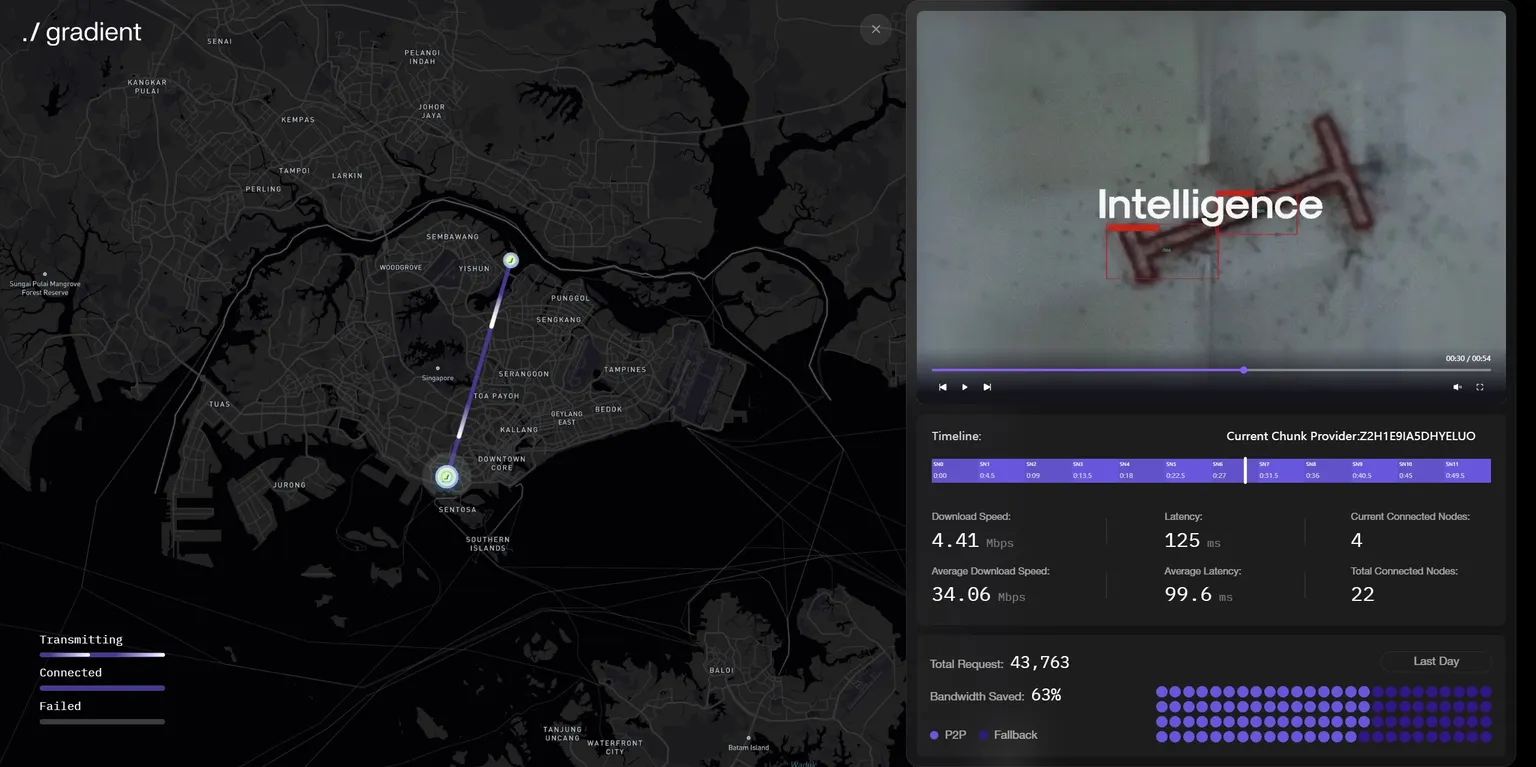

Source: https://explorer.gradient.network/

팀은 Lattica의 성능을 실증하기 위해 여러 캠페인을 진행했는데, 특히 지난 4월에는 크롬 확장 기반의 센트리(Sentry) 노드를 활용한 분산형 비디오 스트리밍 실험을 수행했다. 전 세계 160개 이상의 지역에서 약 800만 개의 센트리 노드가 참여한 이번 실험에서, 영상은 중앙 서버를 거치지 않고 오케스트레이터가 선택한 인근 센트리 노드로부터 P2P 방식으로 직접 전송되어 실시간으로 원활히 재생되는 성과를 거두었다.

향후 Lattica는 단순히 콘텐츠 전송을 넘어, 모델 매개변수 라우팅·분산 추론·에이전트 간 통신 등 탈중앙 AI의 핵심 데이터 흐름을 실시간으로 오케스트레이션할 수 있는 기반 통신 인프라로써 지원하고자 한다.

3.3.2 Parallax — 자기 주권적인 AI OS 프레임워크(Sovereign AI OS Framework)

Lattica가 다양한 통신 환경을 통합해 노드 간 P2P 연결을 매개하는 네트워크 계층이라면, Parallax는 Lattica를 활용하여 작동하는 추론(Inference) 계층으로, 사용자가 완전히 통제할 수 있는 커스텀 클러스터를 구성해 모든 규모의 AI 모델 학습과 추론을 효율적이고 신뢰할 수 있는 방식으로 할 수 있도록 한다.

본질적으로 개인화된 AI 서비스의 효용성과 보안, 그리고 안정성을 극대화하기 위해서는, 서비스를 호스팅하려는 주체가 자신의 AI 클러스터를 직접 통제하고 호스팅할 수 있어야 한다. 하지만 다양한 LLM을 다루는 과정에서 단일 로컬 머신의 성능은 한계에 부딪힐 수 있으며, 더 큰 모델의 학습을 위해 클라우드나 글로벌 GPU 풀을 활용하자니 실행 환경에 대한 통제권이 줄어드는 딜레마가 발생한다. 더욱이 이 경우, 클러스터내 다양한 GPU들 구성 간에는 네트워크 대역폭, 동적 가용성 등 이질적인 요소들로부터오는 운영적인 제약으로 인해 효율적인 스케줄링이 어렵다는 문제가 있다.

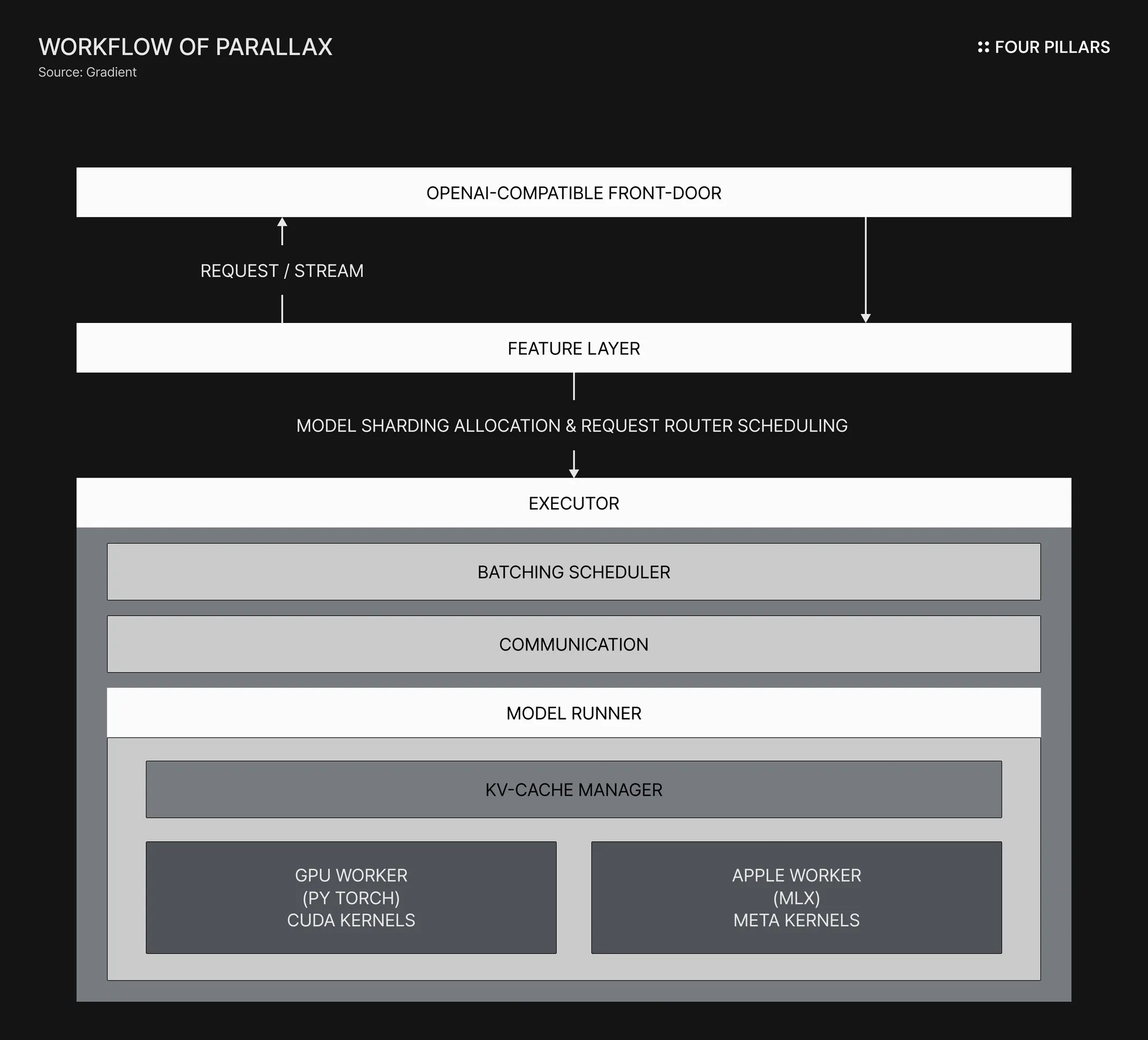

Parallax는 이를 해결하기위해 Lattica 가 제공하는 P2P 통신 네트워크, SGLang 으로 구동되는 GPU 백엔드, 그리고 MLX LM 으로 구동되는 MAC 백엔드 등의 다양한 기저 환경들을 결합한 아키텍처를 활용하여 로컬 환경에서든, 혹은 (대규모 모델의 경우) 공유 GPU 풀을 활용하든, 어느 상황이든 유연하고 장애없이 추론을 위한 노드를 오케스트레이션하고 클러스터를 구성할 수 있도록 한다.

스웜(Swarm)이라는 분산 아키텍처를 기반으로 구축된 Parallax는 클러스트 내 구성된 서로 다른(이기종의) 머신들을 하나의 적응형 메시(adaptive mesh) 로 오케스트레이션하여, 요청마다 최적의 경로를 탐색하고 부하 상황에 따라 추론을 위한 클러스터를 실시간으로 재조직한다. 이를테면, 하나의 거대한 추론 작업을 가장 효율적으로 수행할 수 있도록 여러개의 작업 레이어로 나누어 전세계 여러 유휴 디바이스에 실시간으로 분산할당하는 것이다.

Parallax의 스케줄링 및 추론 작업은 크게 런타임(Runtime), 통신(Communication), 작업자(Worker) 의 세 가지 계층에 걸쳐 실행된다.

스케줄링

Parallax는 모델을 연속적인 레이어 단위로 분할(shard) 한 뒤, 동적 프로그래밍(Dynamic Programming, DP) 과 워터필링(Water-filling) 알고리즘을 활용해 스웜 내에서 가용성, 연산 성능, 지연 시간 등을 종합적으로 고려한 최적의 호스트(예: 노트북, GPU 등)를 식별하고 배치한다 - 이 과정에서 파이프라인의 깊이를 최소화하여 지연을 줄이고, 필요한 경우 복제본을 늘려 처리량을 높이며, 빠른 장비가 느린 장비에 의해 병목되지 않도록 균형을 유지한다.

백엔드 & 통신

통합된 백엔드 계층에서는 NVIDIA 계열의 GPU, Apple Silicon 등 다양한 이기종의 작업자(worker)들이 각자의 하드웨어 성능에 맞춰 최적화된 방식으로 추론을 수행하도록 한다. 모든 노드는 오케스트레이션을 통해 하나의 통합 서비스로 동작하며, 요청은 각 기기의 성능과 노드 간 RTT(Round Trip Time)를 실시간으로 프로파일링한 뒤, 단일 호스트·LAN·퍼블릭 인터넷 중 가장 효율적인 경로를 자동 선택하여 실행된다 - 이때 각 요청은 은닉 상태(hidden state)를 스트리밍 형태로 전송하기 때문에 모든 데이터(혹은 추론 결과)는 안전하고 기밀한 상태를 유지하며 각 레이어를 순차적으로 통과할 수 있다.

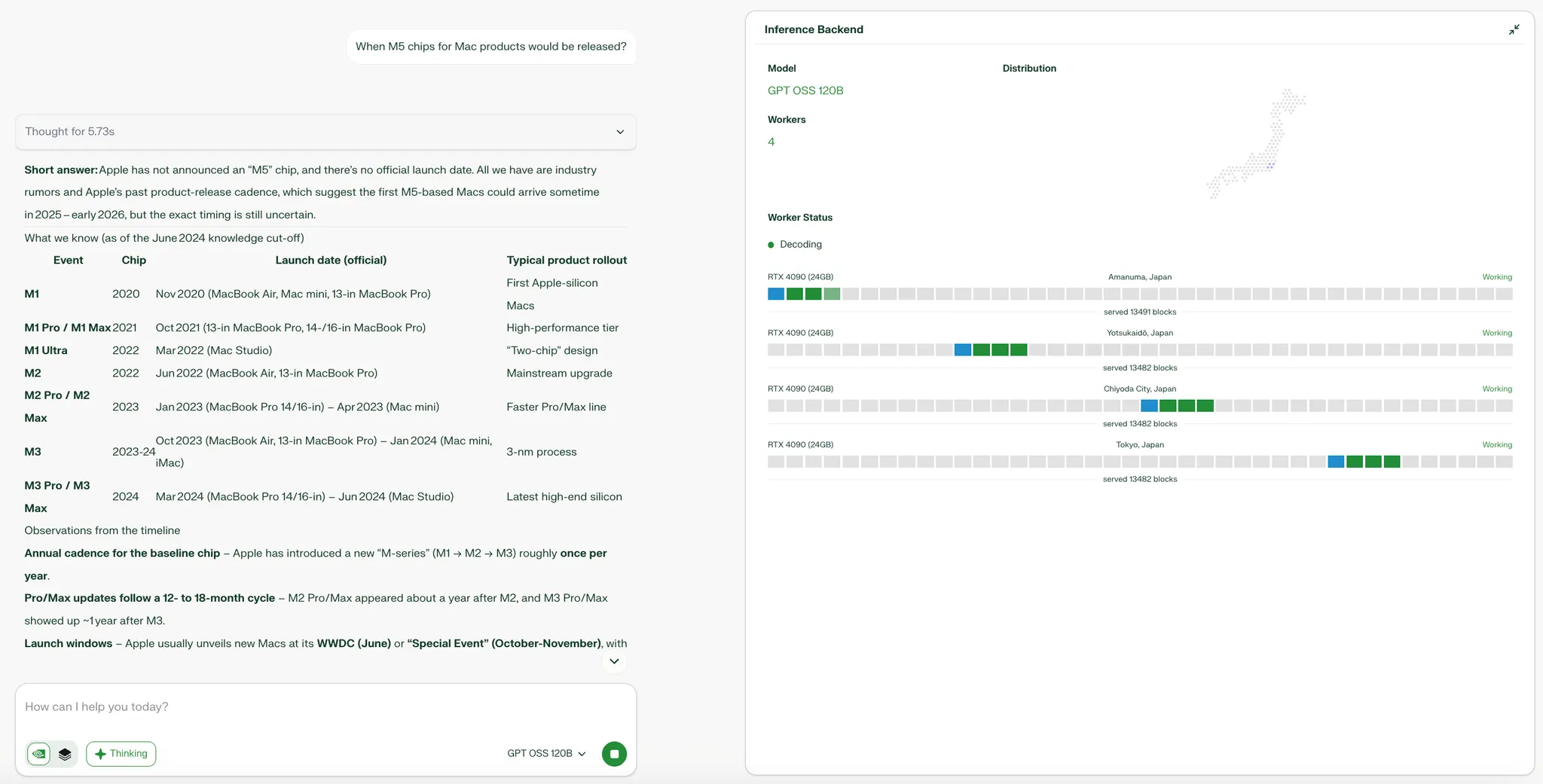

결과적으로, Parallax는 고도로 분산되고 이질적인 환경에서도 하드웨어 간 뛰어난 내결함성(fault tolerance) 과 일관된 추론 성능(performance)을 보여준다. 현재 Parallax는 6억(0.6B) 규모부터 수조(Trillion)-급 Mixture-of-Experts(MoE)에 이르는 40개 이상의 오픈 모델을 지원한다*.

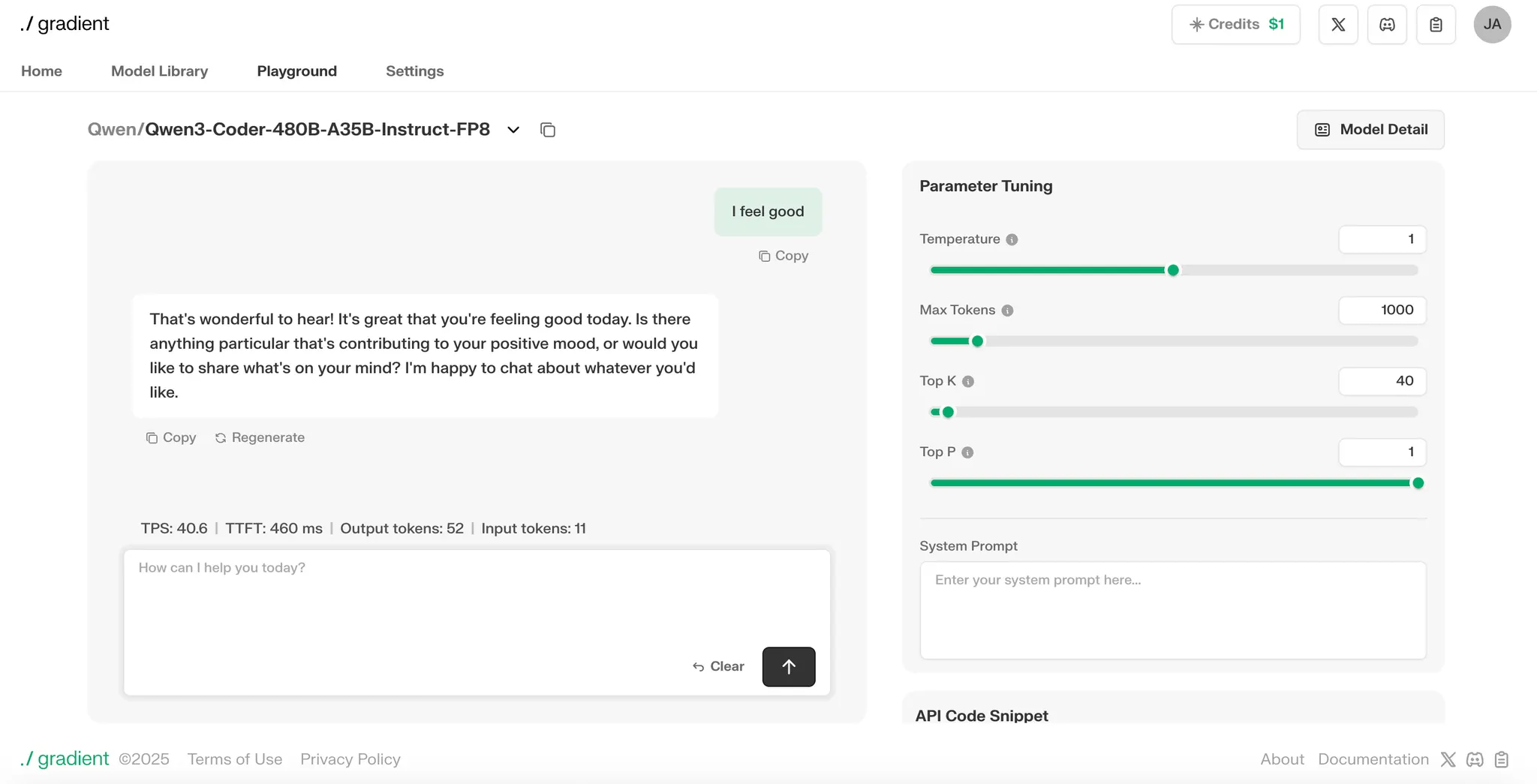

Source: Gradient Chatbot | 현재 Parallax을 통해 구동된 분산화된 추론의 데모 버전이 가용하다

*유수의 MoE·GLM 및 오픈소스 프로바이더인 MiniMax M2, Kimi K2, Z.ai, LMSYS의 SGLang, Alibaba의 Qwen 등이 모두 Parallax와 통합되었다.

3.3.3 Echo - 다양한 디바이스들에 최적화된 분산형 강화 학습 레이어

AI 학습은 크게 두 가지 방식으로 나눌 수 있다. 첫째는 인간의 행동이나 데이터를 관찰하고 이를 모방하는 사전 학습(예: 모방 학습) 방식이며, 둘째는 시행착오를 통해 주어진 시나리오를 반복 수행하고 그 결과에 따라 보상이나 패널티를 부여하는 사후 학습(예: 강화학습(RL), 지식 증류(Knowledge Distillation), 전이학습(Transfer Learning)) 방식이다. 사전 학습은 인간의 패턴을 이해하고 대규모 데이터를 처리하는 데 뛰어난 강점을 지니기 때문에, LLM 등의 영역에서 기반 모델의 발전에 핵심적인 역할을 해왔다. 하지만 앞으로의 에이전트는 더욱 폭넓은 사례의 구현을 위해 단순히 정답을 재현하거나 의사결정을 보조하는 수준을 넘어, 자율적으로 문제를 해결하는 추론(solution-oriented reasoning)을 수행할 수 있어야 한다.

하지만 최신 사후 학습 구조에는 여러 한계가 존재한다. 대부분의 모델이 궤적 샘플링(trajectory sampling) 과 정책 최적화(policy optimization)* 를 동일한 GPU 클러스터 내에서 수행하기 때문이다. 이로 인해 1) 하나의 시뮬레이터 클러스터에서만 롤아웃(rollout)**이 이루어져 데이터 다양성이 부족하고, 2) 특정 환경에 과도하게 의존하여 오버피팅이 발생하며, 3) 학습 중인 정책과 롤아웃에 사용되는 정책 간의 시간 차가 커질 경우 그라디언트(gradient) 업데이트가 불안정해지고, 4) 같은 클러스터에서 궤적을 수집할 때 정책이 바뀌더라도 이전 정책으로 생성된 데이터를 계속 학습하는 정책 반영 지연 문제가 생길 우려가 있다. 이러한 문제점들을 해결하기 위해 최근 강화학습에서는 롤아웃 클러스터와 학습 클러스터를 분리하고, 버퍼 등을 통해 두 클러스터가 독립적으로 작동하도록 설계하는 구조가 제안되고 있다.

그라디언트의 Echo는 이러한 구조를 전 세계의 각 유휴 디바이스 환경에 맞게 최적화한 레이어로, 위의 문제점들을 개선하고 학습 및 추론 과정을 동적인 방식으로 조율하여 에이전트들이 보다 효율적으로 모델링하는 것을 목표로 한다. Echo는 스웜(swarm) 단위로 학습과 추론 과정을 구분하여 각 역할에 따라 효율적으로 작동하도록 설계되었으며, 전 세계의 디바이스들이 동기화 프로토콜(synchronization protocols)들을 통해 연결되어 거대한 롤아웃 워커 네트워크가 안정적이고 유기적으로 작동할 수 있도록 지원한다.

*정책(Policy): 에이전트가 특정 상태에서 어떤 행동을 취하도록 할지 결정하는 전략 또는 규칙

**롤아웃(Rollout); 일정 시간동안 반복적으로 실행하는 정책을 기반으로 에이전트의 성능을 평가하는 과정

우선 추론 스웜(Inference Swarm)은 앞서 언급한 Parallax 프레임워크를 활용한다. 이에 따라 NVIDIA 계열 GPU나 Apple Silicon 등 Parallax가 지원하는 다양한 하드웨어 작업자(worker)들은 각자의 성능 특성에 맞춰 최적화된 방식으로 여러 형태의 롤아웃(rollout)을 샘플링할 수 있다. 반면 학습 스웜(Training Swarm)은 오픈소스 Verl 스택*을 확장하여, A100 및 H100 등 데이터센터급 GPU 환경에서 정책들을 최적화한다.

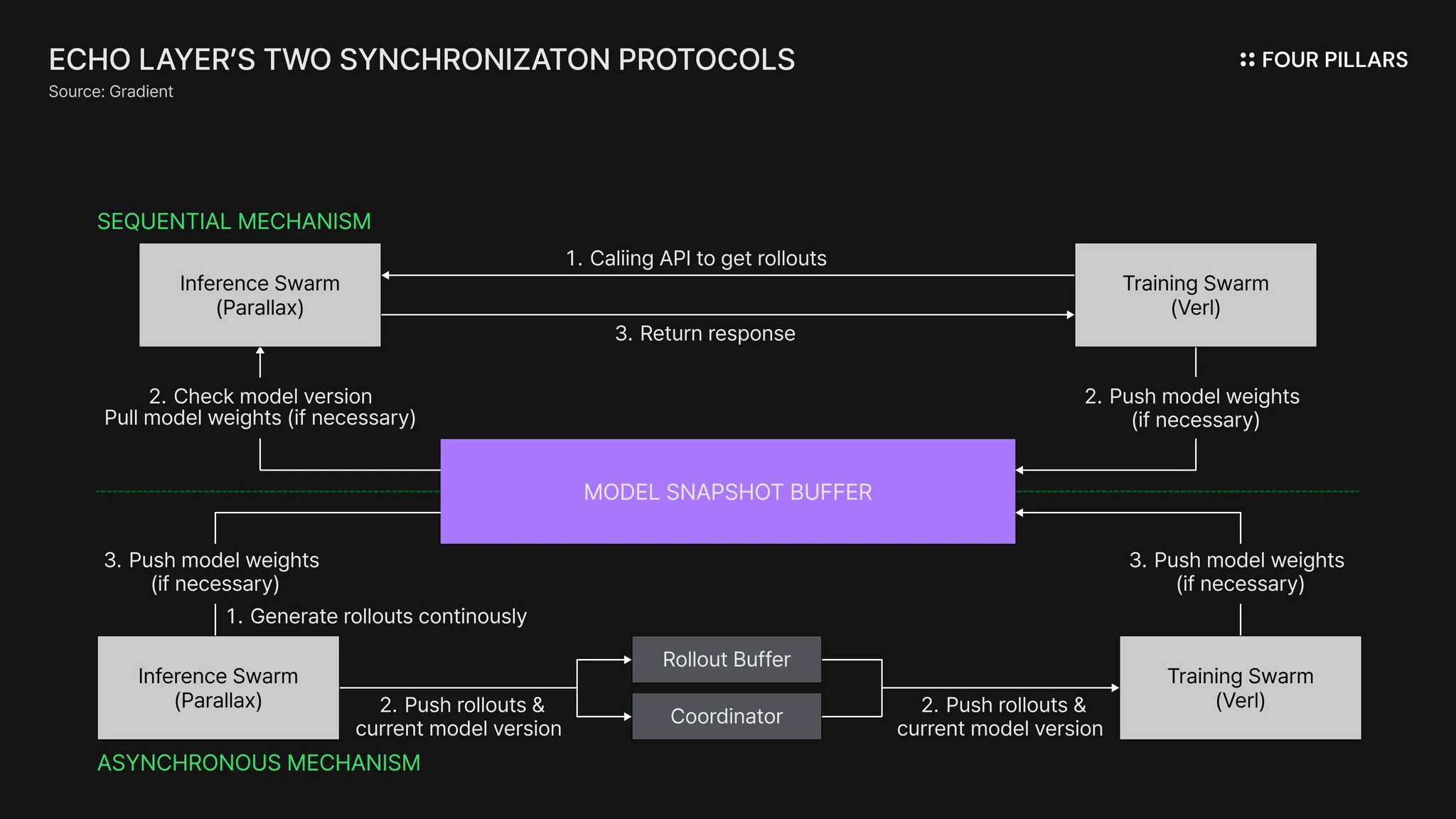

하지만 이러한 이중 구조(dual-architecture) 에서는 필연적으로 롤아웃의 신선도(freshness) 와 정책 최적화의 동기화(synchronization) 사이에 딜레마가 존재할 수 있다. 즉, 추론 결과의 편향(bias)과 정확도(accuracy), 그리고 연산 효율성(computational efficiency) 사이에서 균형을 맞추는 것이 핵심 과제가 되는 것이다. 이를 해결하기 위해 Echo 레이어는 모델 스냅샷 버퍼(model-snapshot buffer) 중심의 두 가지 동기화 메커니즘을 제안하고 각 메커니즘이 목적에 따라 유연하게 활용될 수 있도록 한다.

정책 일관성을 정밀하게 통제하여 높은 정확도와 낮은 편향성을 더욱 중시하는 에이전트 추론을 위해서는 순차적(Sequential) 방식을 제안한다. 이는 주로 기존의 중앙집중식 방식과 유사한데 - 학습 스웜이 중심이 되어 API 호출을 통해 온디맨드 형식으로 스웜에게 궤적을 요청하면 추론 스웜은 모델 스냅샷 버퍼로부터 자신의 로컬 가중치 버전(local weight version) 을 확인한 뒤, 최신 버전이 아닐 경우 이를 갱신하고 롤아웃을 실행하고 그 결과 배치를 호출자에게 스트리밍 방식으로 반환하는 방식이다.

반면, 비동기식 메커니즘(Asynchronous Mechanism)의 경우, 추론 스웜은 롤아웃이 지속적으로 롤아웃 버퍼(Rollout Buffer)로 샘플링 결과를 지속적으로 스트리밍하며, 각 결과에는 해당 시점의 버전 태그(version tag)가 부여된다. 이 때 학습 스웜은 자체 사전 정의된 주기에 맞춰 모델 스냅샷 버퍼에 가중치를 미니배치의 형태로 갱신할 뿐이다. 즉, 추론과 학습이 동시에(concurrently) 진행되며, 이로써 엔드-투-엔드 지연(latency) 을 상쇄하고 학습 효율(training efficiency) 을 극대화할 수 있다.

요컨대, Echo 레이어의 모듈형 아키텍처는 기존의 강화학습 방식에 비해 1) 리소스의 활용을 극대화할 수 있도록 하고, 2) 추론 파이프라인의 배포 유연성(deployment optionality)을 증진시키며, 3) 하드웨어 다양성과 모델 개선이 서로 독립적으로 이루어질 수 있도록하여 병목 현상이나 단일 취약 지점(single point of failure)으로부터 기인하는 성능 저하 문제를 효과적으로 해소한다.

*Verl은 ByteDance Seed 팀이 개발한 강화학습 프레임워크로, PPO, GRPO 등 다양한 강화학습 알고리즘을 지원하는 오픈소스 라이브러리이다.

Source: Gradient

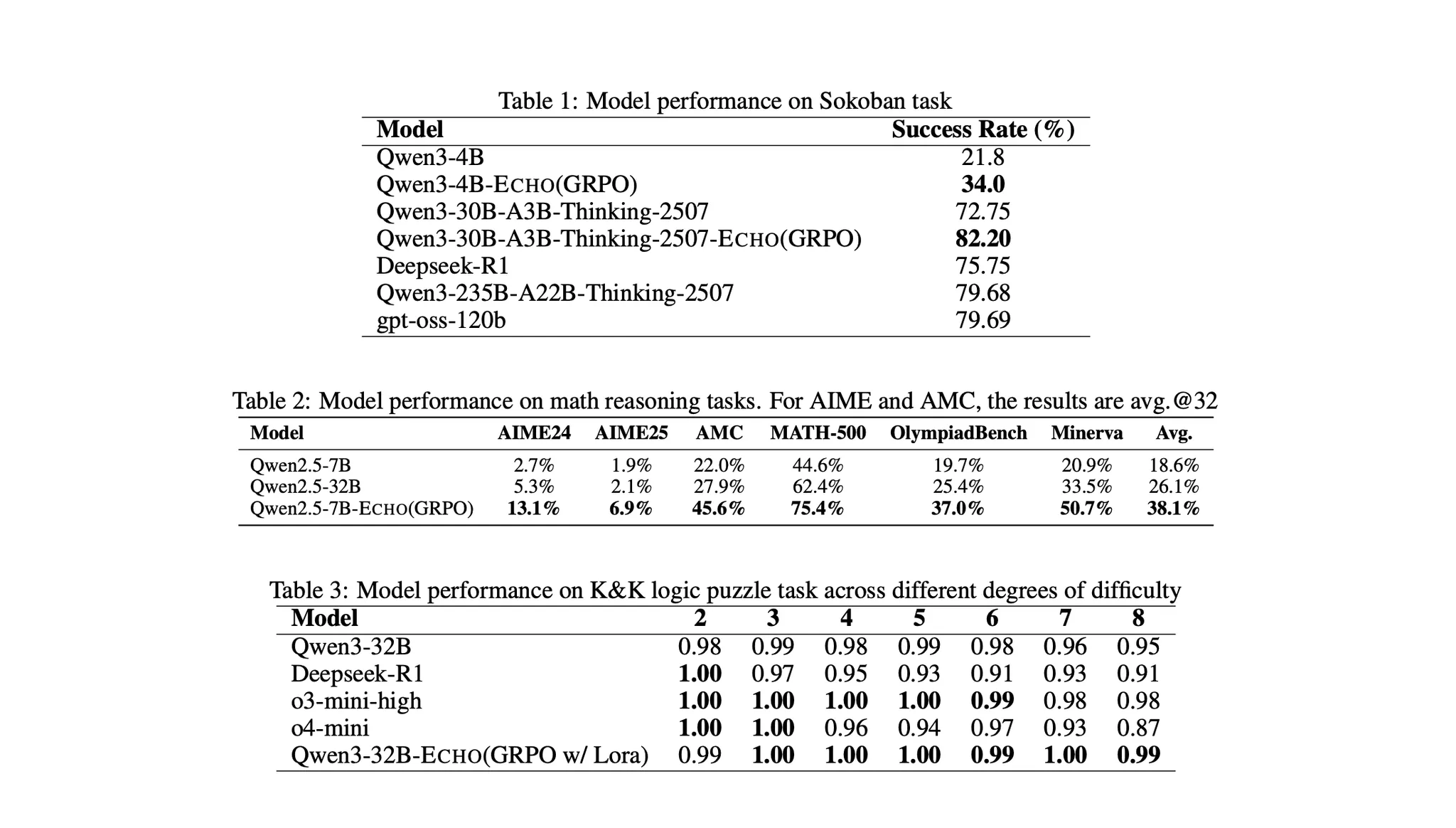

그라디언트의 논문에 따르면, 제안된 방법론의 성능 우수성을 검증하기 위해 기존의 통합형(co-located) 모델과의 벤치마크 비교 실험이 진행되었고 결과는 위와 같다. wen3-4B, Qwen2.5-7B, Qwen3-32B, Qwen3-30B-A3B-Thinking-2507 등 네 가지 Qwen 시리즈 모델이 베이스 모델 대상으로 활용되었다.

VERL 프레임워크(base)

8 × A100 80GB GPU 를 탑재한 단일 머신

Echo 프레임워크

추론(Inference) 스웜

PARALLAX 기반의 분산 네트워크 로 구성총 6개의 노드를 사용 (3대의 RTX 5090 & 3대의 Mac M4 Pro)

학습(Training) 스웜

4 × A100 GPU 를 탑재한 단일 머신

결과적으로, Echo 레이어는 궤적 생성을 범용 하드웨어로 분산시키면서도, 기존의 통합형 방식과 비교하여 동등한 수렴 속도(convergence speed)와 최종 보상(final reward) 을 달성하는 성과를 보여주었다*.

*현재 허깅페이스 컬렉션을 통해 4개의 테스트버전 모델이 공개되어 있다.

3.3.4 Gradient Cloud — 그리고 이 모든 스택을 집약한 기업형 솔루션

Source: Gradient Cloud

그라디언트 클라우드(Gradient Cloud)는 앞서 소개한 세 가지 분산형 스택—Lattica, Parallax, Echo—를 기반으로 구축된 올인원 AI 개발 스테이션으로, 전 세계에 분산된 하드웨어 네트워크를 통해 주요 오픈소스 모델을 위한 추론 엔드포인트와 매개변수를 자유롭게 조정하고 원클릭 배포가 가능한 대화형 플레이그라운드를 제공하고 있다.

향후 로드맵은 앞서 보았던 세 가지의 레이어를 포함하여 완전한 분산형 스택을 계속해서 고도화하여 다양한 산업 분야에서 중앙집중식 스택의 한계를 넘어서는 성능과 확장성을 달성하고, 그라디언트 클라우드 사례와 같이 이러한 기술들을 집약하고 다중 에이전트 간 협업 사례를 활성화할 수 있는 여러 프로덕트를 선보이며, 종국에는 그라디언트 생태계에 흐르는 모든 가치가 다양한 참여자들에게 흘러들어가 함께 이익을 공유할 수 있는 개방형 생태계를 구축하는 것을 목표로 한다.

오늘날 AI는 단순한 정보 수집이나 텍스트 생성의 단계를 넘어, 로보틱스나 가상세계, 그리고 산업 자동화 등 특정 분야에서 복잡한 문제 해결과 자율적 작업 수행을 목표로 빠르게 진화하고 있다. 이에 따라 사용자와 기술 기업들은 기존의 AI 도구를 단순히 활용하는 것을 넘어, 각자의 환경에 최적화된 목적 중심(Purpose-built) AI 에이전트들을 만들고 조합하며 점점 더 정교하고 스마트한 활용 방식을 모색하고 있다.

하지만 이에 맞춰, AI 기술이 산업 전반에서 더 깊고 다양한 영역으로 확장되어 수많은 유스케이스를 열어가기 위해서는 구조적·거버넌스적 개방성이 필수적이다. 누구나 민감한 데이터를 안전하게 활용하고, 자유롭게 모델을 구축하며, 필요한 연산 자원에 접근할 수 있어야 한다. 동시에 이 모든 과정은 검증 가능하고 신뢰할 수 있는 절차적 정당성을 확보함으로써 참여의 민주화를 이뤄낼 수 있어야하고, 이러한 신뢰 기반이 마련될 때 비로소 오픈 인텔리전스 생태계의 플라이휠(flywheel)이 지속적으로 작동할 수 있을 것이다.

이러한 맥락에서 그라디언트의 개방형 인텔리전스 스택(OIS)은 중앙화된 방식보다 훨씬 다양한 컨텍스트에 맞는 추론형 에이전트 모델을 구축하고 호스팅할 수 있는 확장 가능한(Scalable) 인프라를 제공한다. 나아가 OIS는 이러한 인프라를 플랫폼 형태로 구현해냄으로써, 다양한 산업과 환경에서 탈중앙화된 에이전트들이 연결되고 상호작용할 수 있는 무대를 마련하여 분산형 지능 인프라의 핵심 백본(backbone)으로써의 역할을 수행할 잠재력이 충분해 보인다.

하지만 그라디언트에는 아직 관찰되지 않은 몇 가지 리스크도 존재한다. 첫 번째는 다양한 참여자들에 대한 가치 정렬의 문제이다.

그라디언트가 채택하고있는 (블록체인이 효시가 된) 인센티브 기반의 분산화 구조는, 특정 태스크를 수행하면 그에 상응하는 보상을 제공함으로써 불특정 다수의 공급자를 자발적으로 유인하는 데 그 본질이 있다. 즉, 인센티브가 존재할 때 이에 부응하는 공급이 자연스럽게 발생하고, 수요자와 공급자의 상호작용, 그리고 보상 메커니즘이 맞물려 가치의 흐름에 균형이 형성되는 순환적 구조를 전제로 한다. 하지만 이러한 이상적인 시장 조정 메커니즘이 실제로 작동하기 위해서는, 실질적인 가치 창출에 따른 다양한 공급자들의 각 기여 계산과 그에 따른 보상이 합리적으로 책정되어 합의를 이루어야한다.

하지만 그라디언트는 AI 생태계의 학습·추론·데이터·연산 단계를 모듈형으로 통합함으로써, 누구나 참여할 수 있는 개방형 인텔리전스 네트워크를 지향하기때문에 각 레이어마다 많은 종류의 참여자 군이 존재한다. 참여자들의 종류가 많아진다는 것은, 그만큼 경제적 인센티브 정렬의 복잡성이 커진다는 뜻이기도 하다.

더불어 그라디언트가 탈중앙적인 운영을 위해 지분 기반의 네트워크 거버넌스를 도입할 가능성도 충분하다. 하지만 다양한 참여자들의 합의에 기반하더라도 각 모듈의 검증 기준과 보상 체계가 계속해서 변한다면, 신뢰의 척도(trust metric) 는 레이어마다 달라지고 그 안정성 또한 저하될 수 있다. 인센티브가 명확히 정의되지 않거나 보상 체계가 특정 주체에게 편향될 경우, 일부 레이어가 과도한 영향력을 행사하거나 전체 효율을 왜곡시킬 위험도 존재한다.

따라서 그라디언트가 진정한 의미의 오픈 인텔리전스 네트워크로 발전하기 위해서는, 각 모듈의 경제적 유인이 상호 보완적으로 작동하면서 장기적으로 품질 향상을 유도할 수 있는 정교하고 안정적인 인센티브 설계가 필수적이다.

또한 그라디언트가 시장에서 직면한 경쟁 구도 역시 간과할 수 없는 리스크다. 현재 시장에는 비록 구조적인 한계를 가지고 있지만 이를 극복해나가거나 혹은 막대한 자본력을 바탕으로 모델의 성능과 파라미터 최적화에서 절대적 우위를 점하고 있는 OpenAI, Anthropic, Google, Meta 등 기존 웹2 플레이어들이 존재한다. 동시에 데이터·컴퓨팅·모델 학습 등 세부 레이어를 각각 탈중앙화하는 접근을 통해 웹3 진영에서 빠르게 생태계를 확장하고 있는 Gensyn, Bittensor, IO.NET, Aethir 등의 프로젝트도 부상하고 있다. 이러한 환경 속에서 그라디언트는 ‘통합형 인텔리전스 엔진’이라는 독보적인 포지션을 확보하고 있지만, 역설적으로 어느 한 영역에서도 완전한 규모의 경제(economies of scale)를 달성하기 어렵다는 구조적 한계를 지닌다고도 볼 수 있다.

따라서 그라디언트가 이 치열한 경쟁 구도 속에서 지속적으로 지위를 강화하기 위해서는, 단순히 탈중앙화를 표방하는 수준을 넘어 모듈 간 상호운용성과 시장 효율을 결합한 새로운 형태의 네트워크 효과를 창출해야 한다. 요컨대, IO.NET이나 Aethir가 개별 유휴 리소스를 연결하는 데 초점을 맞춘다면, 그라디언트는 이러한 리소스들을 하나의 추론 파이프라인으로 유기적으로 통합하고 조율하는 지능적 오케스트레이션 계층(intelligence orchestration layer) 으로서의 역할을 강화해야 한다. 이러한 방향성이 명확히 확립될 때, 그라디언트는 웹2의 자본 효율성과 웹3의 분산형 개방성을 동시에 흡수하는 하이브리드형 인텔리전스 인프라로 진화할 수 있을 것이다.